10 دقیقه

OpenAI نسخهای جدید به نام GPT-5-Codex-Mini را معرفی کرده است؛ یک نسخه جمعوجور و اقتصادی از مدل کدنویسی Codex مبتنی بر GPT-5 که هدف آن فراهم کردن دسترسی مقرونبهصرفهتر برای توسعهدهندگان به قابلیتهای پیشرفته تولید کد و کمکهای مهندسی نرمافزار است. این نسخه کوچک با هدف کاهش هزینههای محاسباتی طراحی شده تا تیمها بتوانند تعداد بیشتری از کارهای توسعه را با همان بودجه انجام دهند، در حالی که هنوز بسیاری از تواناییهای کلیدی مدل اصلی را حفظ میکند.

What the new mini model offers

GPT-5-Codex-Mini را میتوان به عنوان یک نسخه کوچکتر و بهینهشده از GPT-5-Codex در نظر گرفت که برای کاهش هزینهها و افزایش ظرفیت عملیاتی طراحی شده است. هدف اصلی این مدل ارائه بیشتر قابلیتهای پایهای در حوزه تولید کد شامل ایجاد پروژههای جدید، افزودن ویژگیها و تستها، بازسازیهای گسترده کد (large-scale refactors) و پشتیبانی از تغییرات ساختاری در پایگاه کد است، در حالی که مصرف محاسباتی و هزینههای مرتبط را به طور معنیداری کاهش میدهد.

در عمل، OpenAI اعلام کرده است که نسخه Mini اجازهٔ استفاده تقریباً چهار برابر بیشتر را در مقایسه با نسخه کامل GPT-5-Codex فراهم میآورد؛ این افزایش کارایی با تنها کاهش ملایم در دقت و توان استدلال همراه است، که برای بسیاری از جریانهای کاری تولیدی یک مبادلهٔ جذاب به حساب میآید. به عبارت دیگر، تیمهایی که حجم بالایی از درخواستها و عملیات معمولی یا تکراری دارند، میتوانند از Mini استفاده کنند تا هزینههای کلی کاهش یابد بدون اینکه کیفیت خروجی در سطحی بحرانی افت کند.

از منظر فنی، نسخهٔ Mini احتمالا از ترکیبی از کاهش پارامترها، بهینهسازیهای بایاس-وزن، الگوریتمهای فشردهسازی مدل و تنظیمات اختصاصی برای وظایف برنامهنویسی استفاده میکند تا تعادل میان کارایی، دقت و هزینهٔ اجرا برقرار شود. این رویکردها در زمینهٔ مدلهای زبان بزرگ (LLMs) برای ایجاد محصولات مقرونبهصرفه و مقیاسپذیر شناختهشدهاند و در محیطهای تولیدی که نیاز به پردازش دستهای یا حجم بالای درخواستها وجود دارد، اهمیت ویژهای پیدا میکنند.

How it performs: real benchmark numbers

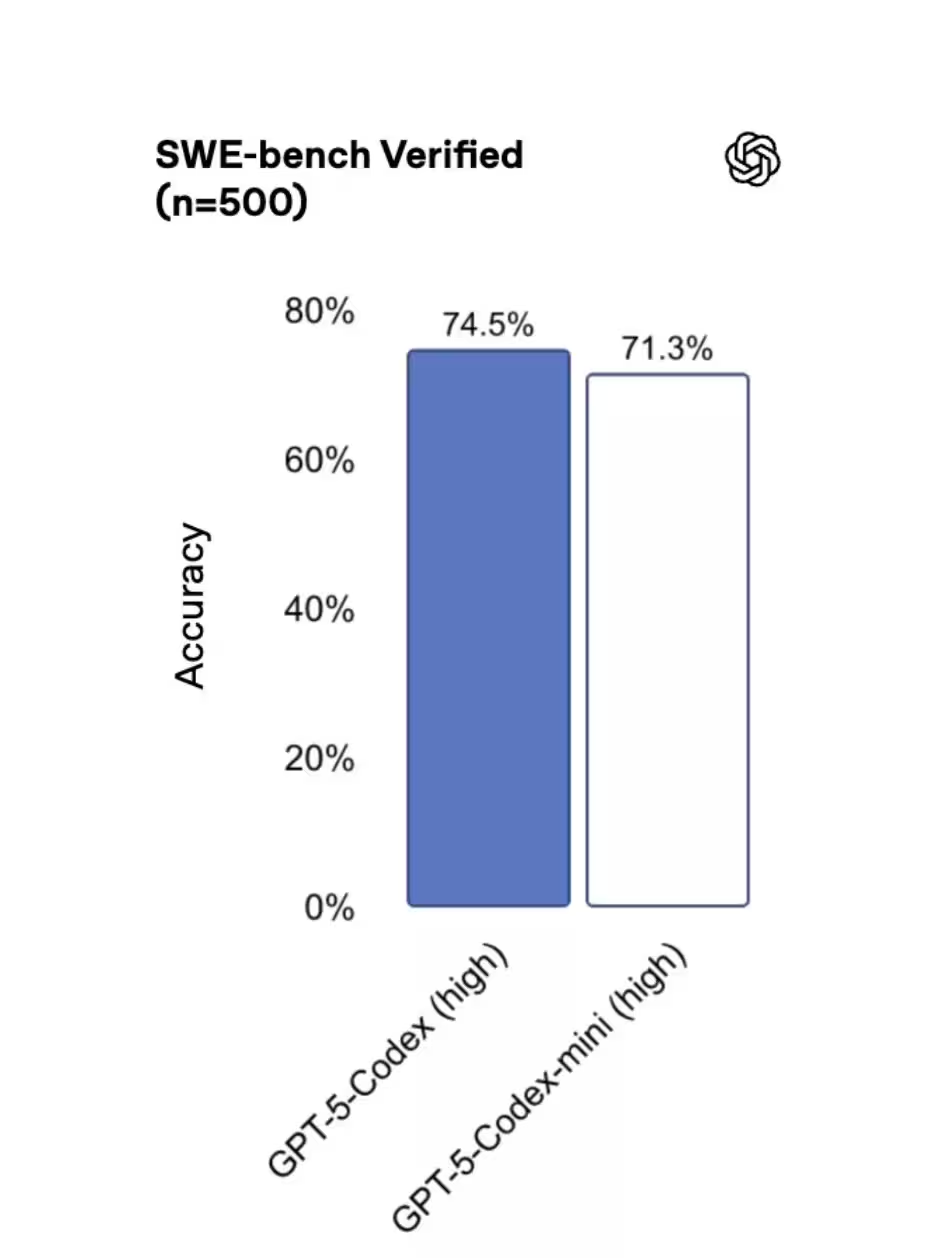

در آزمونهای بنچمارک SWE-bench Verified سه مدل نزدیک به هم ارزیابی شدهاند: GPT-5 High امتیاز 72.8%، GPT-5-Codex امتیاز 74.5% و GPT-5-Codex-Mini امتیاز 71.3% را کسب کردهاند. این نتایج نشان میدهد که نسخهٔ Mini بخش زیادی از نقاط قوت مدل اصلی را حفظ کرده و در عین حال صرفهجویی قابلتوجهی در هزینه را فراهم میکند؛ بنابراین برای بسیاری از جریانهای کاری تولیدی، به ویژه مواردی که هزینه و توان عملیاتی اولویت دارند، یک انتخاب منطقی و جذاب است.

این نوع بنچمارکها به توسعهدهندگان و تیمهای فنی کمک میکند تا تصمیمات مبتنی بر داده اتخاذ کنند: اگر دقت نهایی عملکرد برای شما حیاتی است (برای مثال در تولید الگوریتمهای حساس یا مواردی که اشتباهات هزینهساز هستند)، مدل کامل ممکن است مناسبتر باشد؛ اما اگر حجم درخواستها بالا باشد و وظایف بهطور عمده تکراری یا کمخطر باشند، Mini میتواند تعادل بهتری بین هزینه و عملکرد ارائه دهد.

نکتهٔ مهم دیگر نحوهٔ اندازهگیری عملکرد در بنچمارکهاست: معیارهای مختلف (دقت، توانایی استدلال، پوشش توابع زبانهای برنامهنویسی مختلف، سرعت پاسخدهی و هزینهٔ هر هزار توکن) همگی باید مد نظر قرار گیرند. برای مثال، Mini ممکن است در پاسخهای پیچیده که نیاز به استدلال چندمرحلهای دارند کمی ضعیفتر عمل کند، اما در تولید سریع قطعات کد، تست اتوماتیک و اصلاحات ساختاری حجم بالا عملکردی قابل قبول و پایدار ارائه خواهد کرد.

When developers should pick the Mini

چه زمانی باید از نسخه Mini استفاده کرد؟ OpenAI پیشنهاد میکند GPT-5-Codex-Mini را برای کارهای مهندسی سبکتر، وظایف تکراری یا به عنوان یک الگویی پشتیبان (fallback) زمانی که به محدودیتهای مصرف مدل اصلی نزدیک میشوید، به کار ببرید. ابزارهای Codex حتی پیشنهاد میکنند زمانی که حدود 90٪ از سهمیهٔ مصرفی (quota) شما پر شد، به نسخهٔ Mini سوئیچ کنید تا از رسیدن ناگهانی به سقف مصرف جلوگیری شود.

میتوان به Mini به چشم یک «گازدهندهٔ اقتصادی» (throttle) نگاه کرد: کارهای مهم و حساستر همچنان باید روی مدل کامل اجرا شوند، در حالی که کارهای تکراری، تولید انبوه قطعات کد، نوشتن تستهای خودکار، اصلاحات ساده و تبدیل قالبها را میتوان به Mini سپرد تا بودجه و توان عملیاتی تیم افزایش یابد.

نمونههای کاربردی مناسب برای Mini

- تولید خودکار تستهای واحد (unit tests) برای ماژولهای ساده

- نوشتن کدهای قالبی یا اسکلت پروژه (boilerplate code)

- ترجمهٔ کد بین زبانها در مقیاس زیاد (مثلاً تبدیل توابع ساده از Python به JavaScript)

- اعمال ریفکتورهای ساختاری کمریسک و تغییر نام متغیرها/توابع

- تولید تستهای نگارشی یا بررسی سبک کد (linting suggestions) در حجم بالا

در مقابل، برای وظایف حساس مانند طراحی الگوریتمهای حیاتی، بررسی امنیتی عمیق، یا کدهایی که خطا در اجرای آنها میتواند پیامد سنگین داشته باشد، بهتر است از مدل کامل استفاده شود یا نتایج تولیدی Mini را با بررسی انسانی دقیق ترکیب کنید.

Where you can use it today

نسخهٔ Mini هماکنون در رابط خط فرمان (CLI) و بهصورت یک افزونه برای محیطهای توسعهٔ یکپارچه (IDE plugin) در دسترس است، و پشتیبانی API نیز بهزودی افزوده خواهد شد. این بدان معنی است که توسعهدهندگان میتوانند آن را فورا در جریانهای کاری محلی، پایپلاینهای CI/CD و جلسات کدنویسی مبتنی بر ادیتور ادغام کنند—حتی پیش از تکمیل انتشار گستردهتر API.

در عمل، دسترسی از طریق CLI و افزونهٔ IDE به تیمها امکان میدهد از Mini برای تکمیل خودکار، پیشنهاد کد در زمان واقعی، تولید تست و اصلاحات سریع در محیط توسعه استفاده کنند. وقتی API عمومی فعال شد، ادغام در سرویسهای وب، اتوماسیون سرور و ابزارهای مدیریت پروژه نیز سادهتر خواهد شد، که این امر باعث افزایش مقیاسپذیری و همگرایی در فرایند توسعه نرمافزار میشود.

نکات یکپارچهسازی و عملیاتی

- ادغام در CI: استفاده از Mini برای اجرای کارهای پیشپردازشی در pipelineها (مانند تولید تستهای پایه یا بررسیهای سبک) میتواند زمان اجرای pipeline را کاهش دهد و بار مدل کامل را کم کند.

- استفاده در ادیتورها: افزونهٔ IDE میتواند پیشنهادات کدی سریع، رفع ایرادات سبک و تولید توابع کمکی را به صورت بلادرنگ فراهم کند، که سرعت توسعه را افزایش میدهد.

- مدیریت نسخه و لاگها: هنگام استفاده از Mini در جریانهای تولیدی انبوه، ثبت دقیق درخواستها و پاسخها برای تحلیل کیفیت و بازخورد مدل ضروری است تا نقاط ضعف و خطاها شناسایی و اصلاح شوند.

Behind the scenes: performance and reliability upgrades

OpenAI همچنین تغییرات زیرساختی را اعلام کرده که هدف آنها قابلپیشبینیتر کردن استفاده از Codex است. کار روی بهینهسازی مصرف GPU و تنظیمات مسیریابی (routing optimizations) باعث شده OpenAI محدودیتهای نرخ (rate limits) را برای مشترکان ChatGPT Plus، Business و Education تا 50٪ افزایش دهد. مشتریان Pro و Enterprise نیز از پردازش اولویتدار بهرهمند میشوند تا سرعت و پاسخدهی در زمانهای اوج حفظ شود.

مشکلات قبلی که ناشی از خطاهای کشینگ (caching errors) باعث کاهش ظرفیت قابلاستفاده میشد، برطرف شدهاند، بنابراین توسعهدهندگان باید تجربهای پایدارتر و قابلاطمینانتر در طول روز مشاهده کنند. این اصلاحات زیرساختی معمولا شامل بهبود مدیریت صفها، بازتخصیص منابع محاسباتی و بهینهسازی مسیر دادهها بین سرویسهای مدل و لایههای API است.

در زمینهٔ عملیاتی، این ارتقاءها برای سازمانهایی که نیاز به SLA قابلقبول و توان عملیاتی بالا دارند اهمیت زیادی دارد. افزایش نرخ محدودیتها و اولویتدهی پردازش به مشتریان سازمانی به معنی کاهش تأخیر در پاسخها و جلوگیری از گلوگاههای مصرف است که میتواند تجربهٔ توسعهدهنده و کاربران نهایی را بهبود بخشد.

پیامدهای فنی برای تیمهای توسعه

- پیشبینی هزینه: با توجه به کاهش هزینهٔ هر درخواست در Mini، تیمها قادر خواهند بود نقشهٔ مصرف را بهتر برآورد کنند و بودجهٔ اجرایی را به وظایف مهمتر اختصاص دهند.

- تعادل بار: استفادهٔ ترکیبی از مدل کامل و Mini باعث میشود بار محاسباتی متوازن شود و نیاز به منابع پرهزینه کاهش یابد.

- پایداری خدمات: رفع مشکلات کشینگ و بهینهسازی مسیرها به پایداری طولانیمدت سرویس کمک میکند، که برای پیادهسازیهای تولیدی با ترافیک بالا حیاتی است.

در مجموع، نتیجهٔ کار این است که GPT-5-Codex-Mini به تیمها راهی عملی برای گسترش اتوماسیون کدنویسی ارائه میدهد بدون اینکه هزینهها متناسب با مقیاس افزایش یابد. برای بسیاری از توسعهدهندگان، این نسخه انتخاب هوشمندانهتری برای کارهای با حجم بالا یا کمریسک خواهد بود—خصوصاً در زمانی که OpenAI همچنان دسترسی API را گسترش میدهد و تضمینهای عملکرد را سختگیرانهتر میکند.

ملاحظات امنیتی و حریم خصوصی

هرچند Mini مزایای اقتصادی و مقیاسپذیری دارد، اما باید نکات امنیتی و حریم خصوصی نیز مدنظر قرار گیرند: اطمینان از اینکه دادههای حساس در درخواستها ارسال نشوند، پیادهسازی کنترل رویخروجیهای تولیدی و بررسی خودکار نتایج توسط تیمهای امنیتی برای جلوگیری از نشت اطلاعات یا تولید کد ناامن ضروری است. همچنین پیکربندیهای API و سیاستهای دسترسی باید به گونهای تنظیم شوند که تنها افراد و سرویسهای مجاز توان ارسال درخواست به مدل را داشته باشند.

بهترین روشها (Best Practices)

- استفاده از مدل کامل برای وظایف حساس و Mini برای کارهای تکراری و حجیم

- ثبت (logging) و پایش (monitoring) تمام تعاملات با مدل برای تحلیل کیفیت و شناسایی الگوهای خطا

- اعمال بررسی انسانی بر خروجیهای حیاتی و ترکیب نتایج مدل با تستهای خودکار

- بهکارگیری قواعد و الگوهای ایمنسازی کد (secure coding patterns) هنگام تولید خودکار کد

- استفادهٔ تدریجی و آزمایشی (canary releases) در محیط تولید برای ارزیابی رفتار مدل در مقیاس واقعی

با رعایت این نکات، سازمانها میتوانند از مزایای Mini بهرهمند شوند در حالی که ریسکهای عملیاتی و امنیتی را کنترل کردهاند.

جمعبندی

در پایان، GPT-5-Codex-Mini یک گزینهٔ عملی و مقرونبهصرفه برای گسترش اتوماسیون کدنویسی و بهبود بهرهوری تیمهای توسعه نرمافزار است. این نسخه بهخصوص برای موارد استفادهای که نیاز به حجم بالا، تولید تکراری یا هزینهٔ پایین دارند مناسب است. ترکیب Mini با مدل کامل، بنچمارکگیری منظم، مانیتورینگ و سیاستهای امنیتی مناسب میتواند تجربهٔ توسعهٔ مبتنی بر هوش مصنوعی را هم مقرونبهصرفه و هم قابلاطمینان سازد.

اگر شما یک تیم توسعه هستید که به دنبال افزایش Throughput، کاهش هزینهٔ اجرا و حفظ کیفیت مناسب در وظایف کمریسک میباشید، GPT-5-Codex-Mini میتواند یک ابزار کلیدی در پشتهٔ فناوری شما باشد. با انتشار گستردهتر API و بهبودهای زیرساختی که OpenAI انجام داده، گزینههای یکپارچهسازی و مقیاسپذیری بیشتر نیز در دسترس قرار میگیرند که میتواند هزینههای کلی مالکیت (TCO) را کاهش و بهرهوری را افزایش دهد.

منبع: smarti

نظرات

اتو_ر

یه سوال سریع: وقتی API عمومی بیاد، سوئیچ خودکار quota چطور کار میکنه؟ اگه دستی باشه دردسر میشه؛ الان فقط CLI و افزونه IDE در دسترسه؟

پمپزون

کمی هایپ شده بنظر میاد، چهار برابر استفاده خوبه اما استدلال پیچیده ضعیفه؛ لطفا لاگینگ و کنترل امنیتی قوی بذارن قبل استفاده گسترده.

رضا

توازن هزینه و عملکرد مهمه، بنچمارکها هم نزدیکن. خوبه که انتخاب ارزونتر هست و زیرساخت هم ظاهرا پایدارتر شده، نکتهی امیدوارکنندهاس.

لابکور

تو تیم قبلی ما نسخه کوچک شبیه اینو استفاده کردیم؛ سرعت و throughput رفت بالا اما گاهی ریزباگای عجیبی میداد، پس حتماً تست دستی و لاگگیری بذارید.

توربو

واقعاً 71.3٪ کافیست؟ برای کارهای کمریسک شاید، اما تو پروژههای حساس از کجا بدونیم خطاها کی خودشونو نشون میدن؟ شک دارم...

کوینپ

عقلاییه؛ تقسیم بار بین مدل کامل و Mini کلی منطقیه، مخصوصا برای CI و تولید تست در مقیاس بالا. هزینه کاهش پیدا کنه، کارها سریعتر پیش میره.

دیتاپالس

وااای، چهار برابر استفاده؟! این یعنی تیمای کوچک هم میتونن اتوماسیون گسترده بذارن با هزینه پایین... امیدوارم کیفیت خیلی افت نکنه، ولی خوشحالم!

ارسال نظر