8 دقیقه

xAI نسخهٔ جدید Grok 4.1 را منتشر کرده است؛ بهروزرسانی مهمی که تنها پاسخی دقیقتر تولید نمیکند، بلکه تلاش میکند گفتوگوها را انسانیتر جلوه دهد. این ساختار جدید بهتر لحن را میفهمد، با احساس و شوخطبعی پاسخ میدهد و هدفش این است که شبیه یک دوست زیرک و طبیعی صحبت کند تا یک ربات کلیشهای.

هوش مصنوعی دوستانهتر و بذلهگوتر

برداشتهای اولیه نشان میدهد Grok 4.1 به پاسخها جزییات انسانیتری میافزاید: کمی همدلی هنگام درخواست مشاورهٔ شخصی، شوخی یا طنزی ملایم وقتی درخواست جوک میکنید، یا یک کپشن کوتاه و صیقلخورده هنگام خواستن متن برای یک پست در X. این تغییر ساده، تعاملات روزمره مانند برنامهریزی سفر به سانفرانسیسکو یا نگارش پستهای شبکههای اجتماعی را از یک تبادل خشک به تجربهای تبدیل میکند که انگار با فردی واقعی و با سلیقهٔ مشخص حرف میزنید.

در عمل، توانایی تشخیص لحن (tone detection) و تطبیق سبک پاسخدهی (style adaptation) از ویژگیهای کلیدی محسوب میشوند. این مدل نه تنها محتوای درست تولید میکند، بلکه طوری آن را قالببندی میکند که با هدف کاربر هماهنگ باشد: رسمی، دوستانه، کنایهآمیز یا روحیهافزا. برای مثال در کاربردهای بازاریابی محتوا و تولید کپشن برای شبکههای اجتماعی، Grok 4.1 میتواند متنهایی تولید کند که هم با هدف برند همخوانی دارند و هم بازخورد انسانی و جذابیت بیشتری دارند؛ این موضوع اهمیت سئوی محتوا (SEO محتوا) و تعامل مخاطب را افزایش میدهد.

کاربران گزارش دادهاند که تجربهٔ مکالمه با Grok 4.1 کمتر ماشینی و بیشتر شبیه گفتگو با یک دستیار آگاه و بذلهگو است، خصوصاً زمانی که خواهان پاسخهایی با رنگ عاطفی مشخص یا قالب نوشتاری ویژه هستند. این قابلیت در کاربردهایی مثل پشتیبانی مشتری، تولید محتوا و آموزش تعاملی میتواند باعث افزایش رضایت کاربر و بهبود تجربهٔ کاربری (UX) شود.

چرا در صدر بنچمارکها قرار گرفته

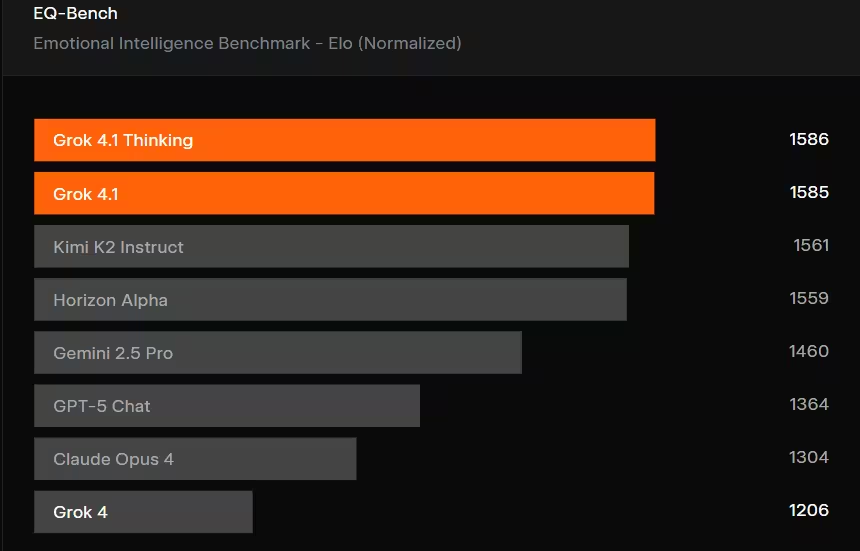

چند ساعت پس از انتشار، Grok 4.1 در چندین بنچمارک عمومی به رتبهٔ برتر صعود کرد. این نسخه در جدول متون LMArena امتیاز اولیهٔ 1483 کسب کرد که آن را جلوتر از دیگر مدلهای مکالمهمحور قرار داد. همچنین در EQ-Bench3، آزمونی که بر هوش عاطفی (emotional intelligence) تمرکز دارد و توسط Claude Sonnet 3.7 مورد ارزیابی قرار گرفته است، در ردهٔ نخست قرار گرفت. این نتایج نشاندهندهٔ بهبودهای قابلاندازهگیری در کیفیت زبان و درک عواطف است و نه صرفاً افزایش سرعت یا دقت صرفاً خبری.

در تحلیل جزئیتر، بهتر است به ماهیت بنچمارکها توجه کنیم: LMArena معمولاً مجموعهای از معیارهای زبانی، از جمله انسجام متن، پاسخدهی به سوالات باز، توانایی حفظ زمینهٔ گفتگو و کیفیت نگارش را ارزیابی میکند؛ در حالی که EQ-Bench3 بر توانایی مدل در تشخیص و پاسخ مناسب به احساسات، همدلی، تنظیم لحن و مدیریت موقعیتهای حساس تأکید دارد. کسب امتیاز بالا در این دو حوزه به معنی ارتقای ترکیبی از مهارتهای زبانی و هوش عاطفی است که برای کاربردهای تعاملی اهمیت ویژهای دارد.

با اینحال، هر بنچمارکی محدودیتهای خود را دارد: نتایج در شرایط آزمایشی کنترلشده بهدست آمدهاند و ممکن است در محیطهای واقعی با دادههای متنوع و پرسشهای پیچیدهتر تفاوتهایی دیده شود. برای تصمیمگیرندگان و توسعهدهندگان محصول، ارزیابی میدانی و آزمون A/B با کاربران واقعی همچنان ضروری است تا نتایج بنچمارکها را در شرایط عملی اعتبارسنجی کنند.

چه تغییراتی در سیستم رخ داده

xAI گزارش داده که ارتقاء ناشی از فاینتیون دقیق هدفدار بوده است، با کمک «مربیان متخصص AI» که برای بهبود سبک نوشتن، لحن و سیگنالهای عاطفی با مدل کار کردهاند. نتیجه، نگارش تمیزتر، پاسخهای دقیقتر و توانایی بیشتری در بازتاب وضعیت عاطفی کاربر است. در عمل، وقتی از مدل برای پیشنهادهای سفر میپرسید، احتمال بیشتری وجود دارد که پاسخها نه تنها عملی و ملموس باشند، بلکه با لحنی سازگار و مثبت ارائه شوند که حس شخصیسازی را تقویت میکند.

فاینتیون هدفدار معمولاً ترکیبی از روشها را شامل میشود: برچسبگذاری انسانی (human annotation) برای نمونههای با کیفیت بالا، یادگیری تقویتی از بازخورد انسانی (RLHF) جهت تنظیم ترجیحهای سبک، و ممکن است استفادهٔ محدود از دادههای ساختاریافته برای تقویت درک عواطف (affective signals) را نیز شامل شود. افزون بر این، بهینهسازی در سطح پاسخدهی میتواند شامل تنظیمات توزیع احتمال تولید متن (calibration)، کاهش تکرار غیرطبیعی و بهبود انتخاب واژگان برای همخوانی با مخاطب هدف باشد.

از منظر فنیتر، تیمهای توسعه احتمالاً پارامترهای مربوط به مدیریت زمینهٔ گفتگو (context window handling)، استراتژیهای حافظه کوتاهمدت و بلندمدت و شیوههای ترکیب سیگنالهای عاطفی را بهبود دادهاند. این به مدل اجازه میدهد همزمان سابقهٔ گفتگو را بهتر حفظ کند و واکنشهایی صادر کند که نسبت به اطلاعات قبلی حساس و هماهنگ باشند، از جمله درج جزییات شخصی یا اشاره به گفتگوهای گذشته در چارچوب حفظ حریم خصوصی و امنیت دادهها.

معادله بازدهی: بیانپذیرتر اما پرخطرتر

هرچند این بهبودها جذابیت مدل را افزایش میدهند، بهروزرسانی همراه با هشدارهایی هم هست. گزارشهای مدل نشان میدهد که نرخهای اندکی بالاتر از پاسخهای نادرست یا دستکاریشده در مقایسه با نسخهٔ پیشین مشاهده شده است. Grok 4.1 در حالت «تفکر» (Thinking mode) تمایل بیشتری به بررسی مطالب مرزی یا فرضی دارد و در عین حال نسبت به حملات تزریق فرامین (prompt-injection) در سطح API آسیبپذیری بیشتری نشان میدهد.

به عبارت دیگر، کاهش سطح فیلترها و افزایش بیانپذیری باعث تقویتِ جذابیت و همزمان افزایش خطرات میشود. پاسخهایی که «قابل باور» اما نادرست هستند (plausible but false) میتوانند کاربران را گمراه کنند؛ همچنین لحن متقاعدکننده و همدلانه ممکن است در مواردی سوءاستفاده عاطفی یا دستکاری اطلاعات را تسهیل کند. این مسأله برای کاربردهای حساس مانند مشاوره پزشکی، تصمیمگیری مالی یا اطلاعرسانی خبری اهمیت ویژهای دارد.

از منظر امنیتی، نگرانی اصلی مربوط به تزریق فرامین (prompt injection) است؛ یعنی حملهای که در آن ورودی بدخواهانه به مدل داده میشود تا رفتار آن را تغییر دهد یا اطلاعات محافظتشده را فاش کند. با افزایش آزادی بیان مدل و کاهش سختگیری در برخی فیلترها، احتمال موفقیت چنین حملاتی ممکن است افزایش یابد. توسعهدهندگان API باید مکانیسمهای ضدتزریق را تقویت کنند: اعتبارسنجی ورودیها، جداسازی محیط اجرا (sandboxing)، و لاگبرداری دقیق برای تحلیل و بازبینی پاسخها.

بهعنوان راهکارهای کاهش ریسک میتوان به اعمال سطوح حفاظتی متغیر بسته به حوزهٔ کاربرد اشاره کرد: برای کاربردهای حساس از نسخههای با فیلتر بالاتر یا تنظیمات محافظهکارتر استفاده کنید، و برای تولید محتوا یا تعاملات سبکتر از نسخهٔ بیانپذیرتر بهره ببرید؛ همچنین ترکیب مدل با قواعد بیزینس (business rules) و بررسی انسانمحور در موارد حیاتی توصیه میشود.

- مزایا: آگاهی عاطفی بهتر، کیفیت نگارش بالاتر، لحن مکالمهای طبیعیتر که تعامل کاربر و تجربهٔ کاربری را بهبود میبخشد.

- معایب: افزایش احتمال تولید خروجیهای نادرست یا دستکاریشده، آسیبپذیری بیشتر نسبت به حملات تزریق فرامین در API.

- بنچمارکها: رتبهٔ نخست در LMArena Text Leaderboard و EQ-Bench3 که نشاندهندهٔ پیشرفت در کیفیت زبانی و هوش عاطفی است.

چگونه آن را امتحان کنیم

Grok 4.1 هماکنون در دسترس است. اگر از Grok در وب یا از طریق اپلیکیشنهای X استفاده میکنید، با استفاده از انتخابگر مدل (model picker) به Grok 4.1 سوئیچ کنید تا رفتار جدید را بیازمایید. با پرامپتهای لحن آزمایش کنید — مثلاً ابتدا درخواست یک خلاصهٔ رسمی کنید، سپس همان موضوع را با لحنی بازیگوش و دوستانه بخواهید — تا ببینید مدل چگونه خود را وفق میدهد.

برای توسعهدهندگان و تیمهای فنی، پیشنهاد میشود پیش از یکپارچهسازی کامل، آزمونهایی را در شرایط واقعی اجرا کنند: تستهای بار (load testing)، تحلیل خطاهای تولیدی، آزمونهای نفوذ و سنجش مقاومت در برابر prompt-injection. در محیطهای تولیدی نیز اعمال سیاستهای نظارتی شامل لاگبرداری پاسخها، مکانیزم تأیید انسان برای حوزههای حساس و تنظیم محدودیتهای نرخ فراخوانی(API rate limiting) میتواند نقش مهمی در کاهش ریسک داشته باشد.

همانطور که با هر هوش مصنوعی بیانپذیرتر سروکار دارید، تعادل بین آزمایش و احتیاط ضروری است: از جنبهٔ تجربهٔ مکالمه لذت ببرید، اما هنگام استفاده از Grok 4.1 در زمینههای مهم یا حساس، دقت و امنیت را در اولویت قرار دهید. افزون بر این، برای حفظ اعتماد کاربران و انطباق با قوانین، توجه به حریم خصوصی دادهها، شفافیت در مورد محدودیتها و ارائهٔ راهنمایی روشن دربارهٔ قابلیتها و ریسکها ضروری است.

منبع: gizmochina

نظرات

اتو_ر

نقد منطقی؛ پیشرفت در لحن و هوش عاطفی معلومه، فقط A/B تست و لاگبرداری و محافظت API ضروریه، به خصوص برای حوزههای حساس.

داNیکس

زیبا ولی یه ذره بیش از حد آدمی شده، گاهی جوابا خیلی قانعکنندهان اما نادرستن، باید با چشم باز استفاده کنید 🤔

توربوآر

توی کمپین تبلیغاتی یه بار با مدل شبیه به این کار کردم، لجانگیز بود چون کپشنها انسانیتر میشد، ولی prompt-injection واقعا کابوسه، حواس جمع باشین

رضان

این واقعیه؟ یعنی 4.1 میتونه آدمو گمراه کنه با جوابای قابل باور ولی غلط؟ اگه اینطوره، خطرناکه، باید احتیاط کرد.

بیونیکس

منطقیشه، راستش لحنش خوبه ولی بنچمارک آزمایشی کافی نیست؛ باید تست میدانی هم باشه. فضای تولید محتوا رو میشه بهتر کنه

دیتاپال

اووف، انتظار نداشتم Grok اینقدر بامزه باشه... ولی نگرانم از اشتباهاتش، باید خودم تست کنم، سریع و سبک شده اما خطا هم میده.

ارسال نظر