9 دقیقه

مقدمه

تیم تحقیقاتی اپل تصمیم گرفت پرسشی ساده اما نگرانکننده مطرح کند: مردم واقعی در عمل از عاملهای هوش مصنوعی که در انجام کارهای روزمره کمک میکنند، چه انتظاری دارند؟ پاسخ یکپارچه و مرتب نیست. پاسخ پیچیده، انسانی و مملو از سازشها و توازنهای طراحی است. این مطالعات نشان میدهد که تجربه کاربری (UX) با عاملهای هوش مصنوعی ترکیبی از شفافیت، کنترل، و مدلهای ذهنی کاربران است که باید بهدقت طراحی شود تا هم قابلاعتماد و هم کاربردی باقی بماند.

روششناسی تحقیق

مرور کلی مقاله و چارچوب تحقیق

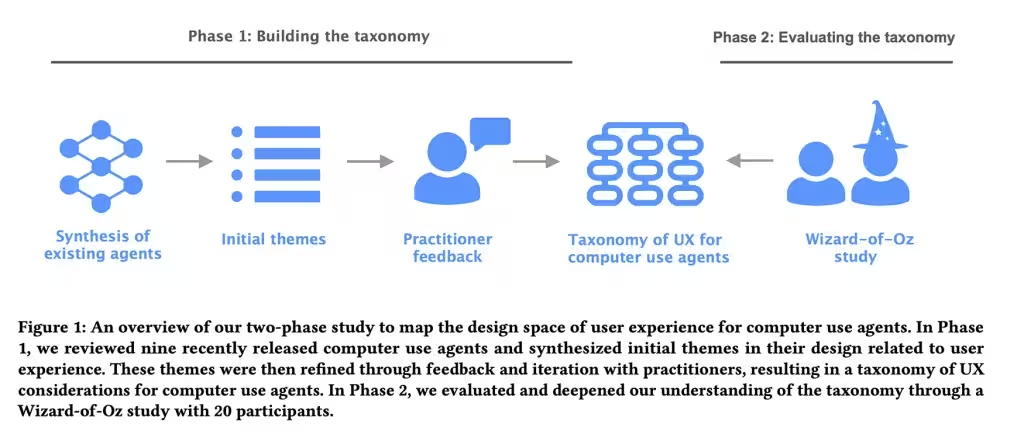

در مقالهای با عنوان نقشهبرداری فضای طراحی تجربه کاربری برای عاملهای استفاده از رایانه، پژوهشگران نه عامل موجود را بررسی کردند — نامهایی مانند Claude Computer Use Tool، Adept، OpenAI Operator، AIlice، Magentic-UI، UI-TARS، Project Mariner، TaxyAI و AutoGLM — تا نحوه ارائه قابلیتها، رفتار در مواجهه با خطاها و شیوه دعوت از کاربر برای کنترل را شناسایی کنند. در فاز اول، تیم متشکل از هشت متخصص UX و هوش مصنوعی چشمانداز را به چهار دسته اصلی، 21 زیرشاخه و 55 ویژگی طراحی ملموس تبدیل کردند. این ویژگیها از نحوه وارد کردن دادهها به عامل تا میزان شفافیت اقدامات عامل و گستره کنترل کاربر و چگونگی شکلگیری مدلهای ذهنی و انتظارات را شامل میشد.

آزمایش «جادوگر اوز» (Wizard of Oz)

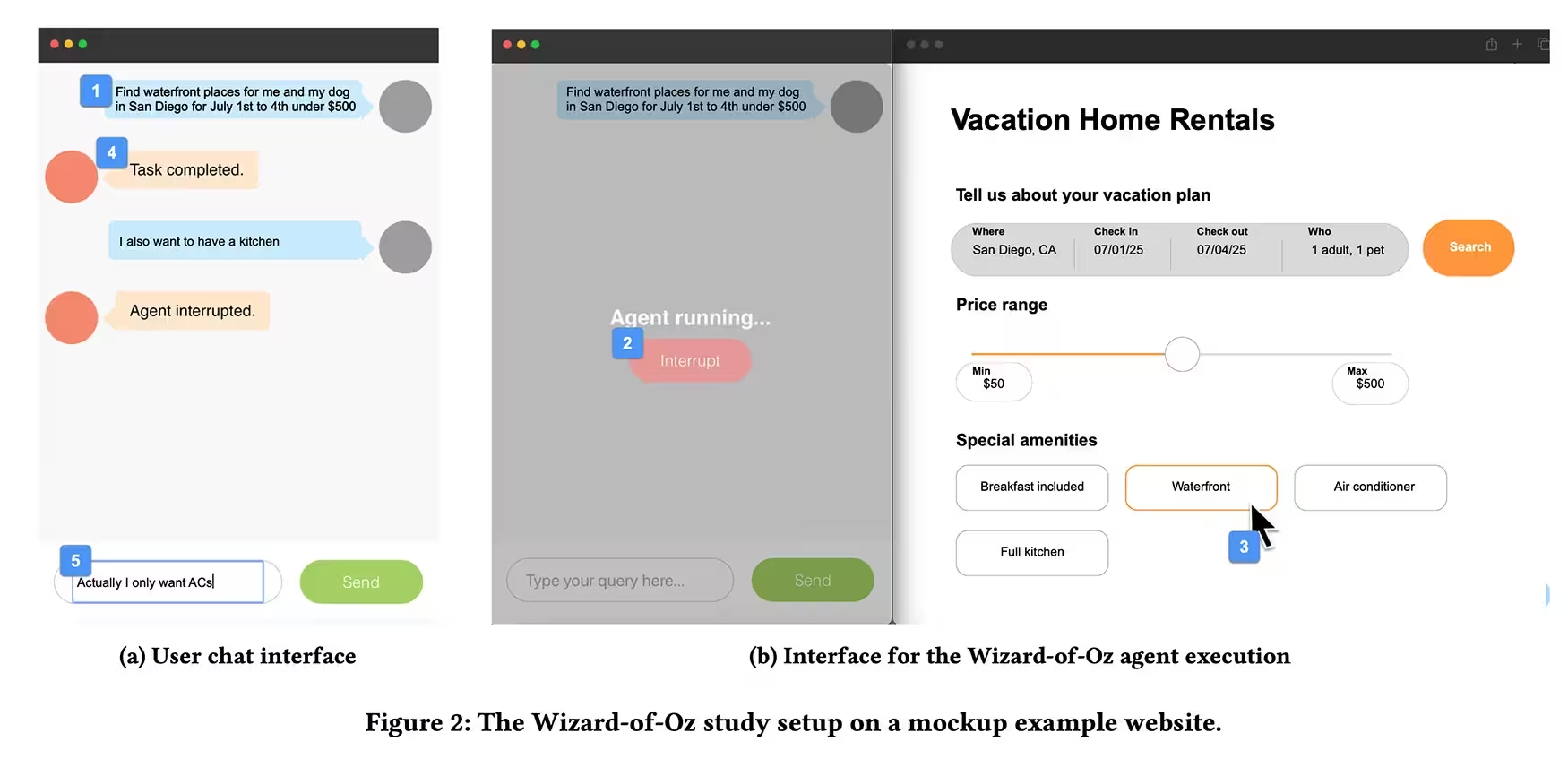

در فاز رونمایی، تیم یک آزمایش نوع «جادوگر اوز» را اجرا کرد. بیست شرکتکننده که تجربه پیشین استفاده از دستیارهای هوش مصنوعی داشتند، از طریق یک رابط گفتوگویی وظایفی مانند رزرو تعطیلات یا خرید آنلاین را به عامل واگذار کردند، در حالی که یک پژوهشگر پشت صحنه با صفحهکلید و ماوس عملاً عامل را کنترل میکرد. شرکتکنندگان میتوانستند دستور تایپ کنند و با فشردن دکمه توقف، عامل را قطع کنند. برخی از وظایف عمداً با خطاها یا وقفههای غیرمنتظره خرابسازی شدند تا واکنش مردم زمانی که عامل اشتباه میکند یا پیشفرضهایی میگیرد، مشاهده شود.

یافتههای کلیدی و تحلیل

الگوهای رفتاری کاربران

از آزمایشها یک الگوی مشخص بیرون آمد: مردم میخواهند بدانند عامل چه کاری انجام میدهد، ولی تمایلی به ریزمدیریت هر کلیک یا اقدام ندارند. نمایشهای کوتاه و تاییدیههای گاهبهگاه سبب آرامش کاربران میشود. سکوت کامل عامل شک و تردید ایجاد میکند و اتوماسیون ناگهانی بدون توضیح نیز همین اثر را دارد. تازهکاران به توضیحات گامبهگام و نقاط بازبینی نرم (soft checkpoints) احتیاج دارند، بهویژه وقتی اقدامات پیامدهای ملموس دارند — مانند خریدها، تغییرات حساب کاربری یا هر چیزی که با یک حرکت قابل بازگشت نباشد. در مقابل، کاربران خبره ترجیح میدهند عامل همانند یک همکار مورداعتماد عمل کند نه دستیار محتاط.

اعتماد و شکنندگی آن

مطالعه نشان میدهد اعتماد مانند شیشه رفتار میکند: شکننده و سریع در معرض شکست. پیشفرضهای پنهان یا خطاهای کوچک، اعتماد را سریعتر از نحوه عملکرد روان و درست، تضعیف میکنند. وقتی عامل از سناریوی مورد انتظار خارج میشود یا با ابهام مواجه است، شرکتکنندگان ترجیح دادند عامل متوقف شود و سوالی بپرسد بهجای آنکه حدس بزند و عمل کند. این ترجیح حتی زمانی که تاییدهای اضافی کمی آزاردهنده بهنظر میرسید هم پابرجا بود — گویا کاربران میگفتند «ایمنتر بهتر از پشیمانی است». این یافته اهمیت طراحی تعاملات شفاف و کنترلپذیر را در سیستمهای عاملهای هوش مصنوعی برجسته میسازد.

چه عواملی شفافیت را تعیین میکنند؟

شفافیت تنها نشان دادن فعالیت جاری نیست؛ شامل نمایش نیت (intent)، فرآیند تصمیمگیری و پیامدهای محتمل هر اقدام نیز میشود. در چارچوب 55 ویژگی طراحی، عناصر مؤثر بر شفافیت شامل موارد زیر بودند:

- نمایش پیشرفت و مراحل (progress & steps)

- توضیحات مختصر درباره دلیل انتخاب یک اقدام (explainability)

- قابلیت متوقفسازی و بازگرداندن عملیات (interruptibility & reversibility)

- تنظیمات سطح اظهارنظر و توضیح متناسب با تخصص کاربر (adaptive explanations)

شاهکلیدهای طراحی برای تولید تجربه کاربری بهتر

تطبیق شفافیت و کنترل با وظیفه و سطح تجربه

عاملهای هوش مصنوعی باید سطح شفافیت و کنترل را متناسب با ماهیت وظیفه و تجربه کاربر تنظیم کنند. این توصیه عملی نقطهاتکای طراحان و تیمهای محصول است: طراحی رابطهایی که نیت و روند را نشان دهند، اجازه توقف یا اصلاح ساده را بدهند و میزان توضیح ارائهشده را براساس اهمیت وظیفه و آشنایی کاربر با ابزار تنظیم کنند.

راهنماییهای عملی برای طراحان و تولیدکنندگان اپلیکیشن

برای طراحان و سازندگان برنامهها، پیامدها عملی و قابلاجرا هستند. چند پیشنهاد کاربردی و مبتنی بر نتایج مطالعه عبارتاند از:

- نمایش نیت و مراحل: از طریق نمایشهای گرافیکی ساده یا پیامهای متنی کوتاه نشان دهید عامل چه قصدی دارد و در چه مرحلهای است.

- قابلیت توقف و اصلاح آسان: دکمههای واضح «توقف» یا «لغو» و گزینههای بازگرداندن (undo) را در دسترس بگذارید تا کاربر احساس کنترل کند.

- توضیحات تطبیقی: برای وظایف حساس مانند پرداخت یا تغییر در حساب، توضیحات گامبهگام ارائه دهید و برای کاربران خبره حالت خلاصهتری فراهم کنید.

- نقاط اطمینان نرم: قبل از انجام اقداماتی با پیامد بالا، یک پنجره تایید یا خلاصه عملیاتی نشان دهید تا کاربر فرصت بازبینی داشته باشد.

- الگوهای خطا و بازخورد: وقتی خطا رخ میدهد، پیامهای خطا واضح، قابلفهم و راهحلمحور ارائه کنید تا مدل ذهنی کاربر حفظ شود.

چارچوب قابل آزمون

مقاله یک چارچوب کاربردی فراهم میکند — نه صرفاً تئوری بیفایده — که شامل چهار دسته و دهها ویژگی است که میتوانند آزمایش، تکرار و اندازهگیری شوند. این چارچوب به تیمها اجازه میدهد تصمیمات طراحی را بر اساس رفتار واقعی کاربران سنجیده و اصلاح کنند. برای مثال، میتوان میزان شفافیت لازم برای یک عمل خرید آنلاین را با آزمایشهای A/B و معیارهایی مانند نرخ تایید کاربر، زمان تکمیل وظیفه و نمرات اعتماد (trust scores) سنجید.

تحلیل تخصصی: چرا فقط مدلهای هوشمند کافی نیستند

تعاملات هوشمند، نه فقط مدلهای هوشمند

مسئله تنها پیشرفت در مدلهای زبانی یا الگوریتمهای تصمیمگیری نیست؛ مسئله طراحی تعاملات هوشمند است. حتی بهترین مدلها وقتی در تجربه کاربری مناسب قرار نگیرند، نمیتوانند اعتماد کاربران را جلب کنند. تعاملات کوچک روزانه — یک تاییدیه در زمان مناسب، یک گام قابل مشاهده، توقف بهموقع هنگام تردید عامل — تعیین میکنند که آیا کاربران اتوماسیون را میپذیرند یا آن را خاموش میکنند.

تطبیق با تخصص کاربر

کاربران خبره و مبتدی دیدگاههای متفاوتی نسبت به اتوماسیون دارند. سیستمهای موفق باید توانایی شخصیسازی سطح تعامل را داشته باشند: حالت «همکار مورداعتماد» برای کاربران خبره و حالت «راهنمای قدمبهقدم» برای تازهکاران. این تطبیق میتواند از طریق تنظیمات اولیه، یادگیری رفتار کاربر و یا پرسشهای کوتاه سازگار در میان تعاملات انجام شود.

پیامدهای فنی و اندازهگیری

از منظر فنی، پیادهسازی این توصیهها مستلزم جمعآوری و آنالیز دادههای تعامل (interaction telemetry)، تعریف معیارهای اعتماد و شفافیت (مثلاً نرخ توقف، نرخ بازگشت عملیات، نمرات رضایت) و ایجاد مکانیزمهای پیشبینی برای تعیین زمانی است که عامل باید سوال بپرسد یا اقدام کند. این امر نیازمند همکاری میان تیمهای مهندسی، طراحی UX، و پژوهشگران کاربردپذیری (usability researchers) است.

ملاحظات اخلاقی و حریم خصوصی

شفافیت در برابر حفظ حریم خصوصی

افشاءگرایی (transparency) همیشه به معنای انتشار تمامی دادهها یا منطق نیست. طراحان باید تعادلی میان شفافیت و حفاظت از حریم خصوصی برقرار کنند. توضیح درباره نیت و نتایج کافی است، در حالی که جزئیات حساس مربوط به دادههای شخصی یا مدلهای اختصاصی میتواند محافظت شود. کاربران باید بدانند چه دادهای استفاده شده و چگونه میتوانند دسترسی یا حذف آن را درخواست کنند.

مسئولیتپذیری و توضیحپذیری

وقتی عامل اشتباه میکند یا تصمیمی میگیرد که پیامد منفی دارد، لازم است مکانیزمهای گزارشدهی و بازخورد وجود داشته باشد تا مسئولیتپذیری تضمین شود. این شامل امکان بازنگری تصمیم، گزارش خطا و دریافت توضیحات قابلفهم توسط انسان است.

نتیجهگیری و اقدامهای بعدی

خلاصه آنکه این مطالعه به ما میگوید: طراحی عاملهای هوش مصنوعی باید حول محور تعاملات هوشمند و قابلاعتماد شکل بگیرد. نه فقط مدلهای پیشرفته، بلکه تصمیمات کوچک طراحی — تاییدیهها، نمایش مراحل، توقفهای بهموقع — تعیینکننده پذیرش یا رد اتوماسیون توسط کاربران خواهند بود. برای تیمهای محصول و توسعه، توصیه روشن است: رابطهایی بسازید که نیت و پیشرفت را نشان دهند، امکان توقف و اصلاح را ساده کنند و بسته به اهمیت وظیفه و سطح دانش کاربر مقدار مناسب توضیح را ارائه دهند.

گامهای عملی پیشنهادی

- پیادهسازی نقاط بازبینی نرم برای عملیات حساس.

- طراحی نمایشهای شفاف از نیت عامل و مراحل اجرا.

- توسعه تنظیمات تطبیقی برای سطوح توضیح متفاوت برای کاربران مبتدی و خبره.

- تعریف و سنجش معیارهای اعتماد و پاسخ به خطا در محیطهای آزمایشی و واقعی.

در نهایت، موفقیت در تجربه کاربری عاملهای هوش مصنوعی نیازمند ترکیب مدلهای هوشمند، طراحی تعامل آگاهانه و ملاحظات فنی و اخلاقی است. با رعایت این اصول، میتوان راه را برای اتوماسیون قابلاعتماد و مفید هموار کرد.

منبع: smarti

نظرات

رضا

واقعاً همیشه باید عامل قبل از عمل سوال کنه؟! تو بعضی موارد صبر و سرعت مهمتره، اگر نه کارا کند میشه...

لابکور

معقول بهنظر میاد. نقاط بازبینی نرم و توضیحات تطبیقی واقعا لازمن. امیدوارم جزییات پیادهسازیشم بذارن

دیتاپالس

وای، انتظار نداشتم اینقدر جزئیات درباره شفافیت و کنترل باشه. خیلی کاربردی ولی پیادهسازیش سخته...

ارسال نظر