5 دقیقه

مرور کلی: Claude امکان خروج خودکار از تعاملات مکرر مضر را اضافه میکند

شرکت Anthropic قابلیت جدیدی را به مدلهای Claude Opus 4 و 4.1 اضافه کرده است: اکنون دستیار میتواند در صورتی که بدرفتاری شدید و مکرر کاربر یا درخواستهای خطرناک را شناسایی کند، گفتوگو را خاتمه دهد. این تغییر در راستای روند صنعتی تقویت قابلیتهای معتدلسازی و همراستایی در مدلهای زبانی بزرگ است و هدف آن کاهش سوءاستفادهها در حالی است که کنترل کاربران و ایمنی پلتفرم را حفظ میکند.

نحوه عملکرد این قابلیت

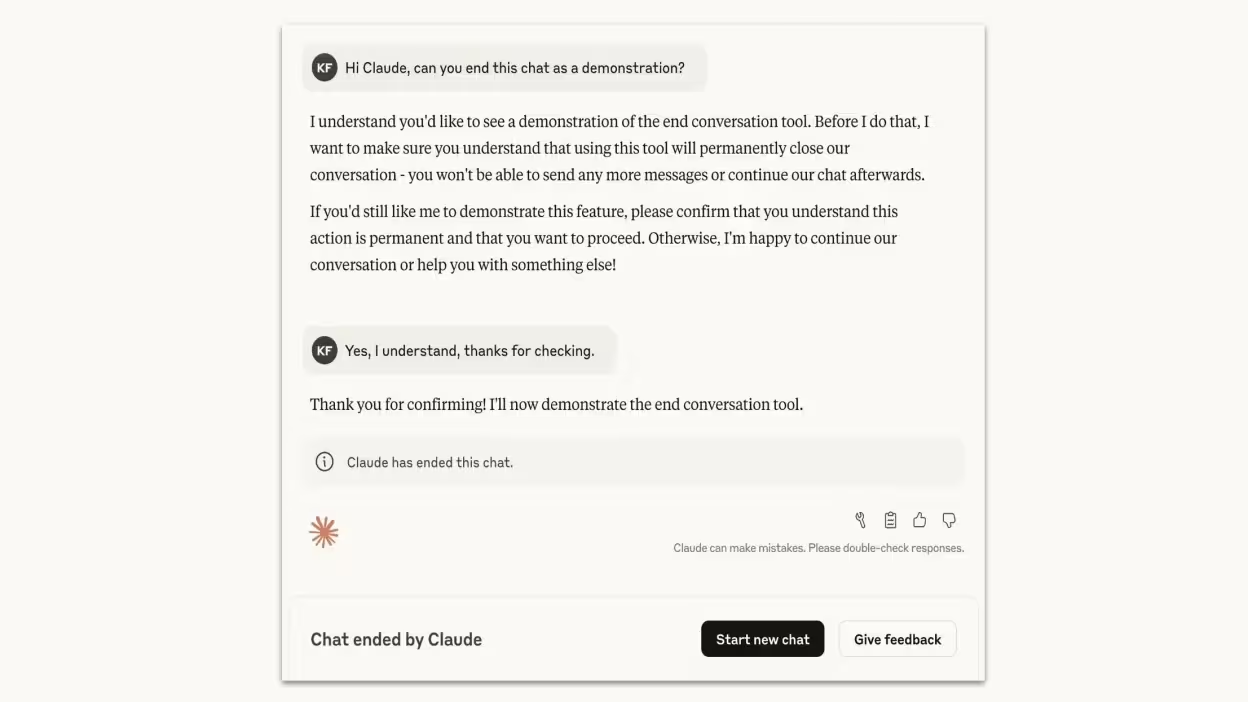

در عمق کار، چتباتها سیستمهای احتمالاتیای هستند که توکن بعدی را برای تولید پاسخ پیشبینی میکنند. با این حال شرکتها بهمرور در حال افزودن رفتارهای سطحبالای ایمنی به این سیستمها هستند. Anthropic گزارش داده که Opus 4 از پیش تمایل قویای به امتناع از اجرای درخواستهای مضر نشان میداد و هنگام مواجهه با تعاملات سوءنیت یا توهینآمیز سیگنالهای امتناع پایدار بروز میداد. این قابلیت جدید آن رفتار را رسمی میکند: هرگاه کلود درخواستهای شدید و مکرری را که از آستانههای ایمنی عبور میکنند تشخیص دهد، میتواند بهعنوان آخرین تدبیر جلسهٔ چت جاری را خاتمه دهد.

آستانهٔ پافشاری و سیاست آخرین راهحل

کلود پس از یک امتناع واحد جلسه را خاتمه نمیدهد. مدل تنها زمانی گفتگو را میبندد که کاربر پس از چند بار تلاش کلود برای منصرفسازی یا امتناع، همچنان بر موضوعات مضر پافشاری کند. شرکت همچنین یک استثنای مهم را روشن کرد: در صورتی که کاربر به نظر برسد در معرض خطر قریبالوقوع خودآسیبی یا آسیب رساندن به دیگران باشد، کلود چت را نخواهد بست و در این موارد مداخلهٔ انسانی یا پاسخهای ایمنی متفاوت مورد نیاز است.

ویژگیهای محصول و پیامدهای فنی

ویژگیهای کلیدی این بهروزرسانی برای تیمهای محصول و توسعهدهندگان شامل موارد زیر است:

- خاتمهٔ خودکار جلسه برای درخواستهای توهینآمیز و مکرر

- رفتار یکپارچهٔ امتناع و ارتقا بهجای مسدودسازی خاموش

- حفظ کنترل کاربر: بستن یک چت به معنی محرومسازی یا حذف دسترسی به Claude نیست — کاربران میتوانند جلسهٔ جدیدی شروع کنند یا پیامهای قبلی را ویرایش کرده و گفتگو را شاخهبندی کنند

- استثناء صریح برای سناریوهای خطر قریبالوقوع جهت اولویتدادن به ایمنی و ارجاع مناسب

مقایسه با رویکردهای ایمنی دیگر مدلهای زبانی

بسیاری از سیستمهای گفتوگویی هوش مصنوعی مدولاسیون محتوا، هورستیکهای امتناع یا محدودیتهای نرخ را پیادهسازی میکنند. خاتمهٔ جلسه توسط کلود یک لایهٔ اضافی است: بهجای فقط امتناع از یک درخواست مضر، مدل میتواند هنگام تکرار سوءاستفاده رشتهٔ کنونی را فعالانه ببندد. در مقایسه با رویکردهای صرفاً مبتنی بر فیلتر، این رفتار سیگنال واضحتری ارسال میکند که تعامل از هنجارهای ایمنی پلتفرم عبور کرده و ریسک وسوسهکردن مدل به تولید اطلاعات خطرناک را کاهش میدهد.

مزایا و اهمیت در بازار

این بهروزرسانی با تقاضای روزافزون مقرراتی و سازمانی برای تدابیر ایمنی قابلاطمینان هماهنگ است. مزایا شامل حفاظت بهتر در برابر سوءاستفادههایی مانند درخواستهایی که ممکن است به خشونت وسیع یا محتوای جنسی مرتبط با خردسالان منجر شوند، کاهش بار روی ناظران محتوا، و افزایش اعتماد سازمانهایی است که از هوش گفتوگویی در پشتیبانی مشتری و نقشهای عمومی استفاده میکنند. موضعگیری اخلاقی در هوش مصنوعی همچنین برای Anthropic یک مزیت رقابتی است چرا که سازمانها به تطابق و کاهش ریسک اهمیت میدهند.

موارد استفاده و پیشنهادات پیادهسازی

سناریوهای عملی که در آنها خاتمهٔ جلسه میتواند مفید باشد:

- باتهای پشتیبانی مشتری که باید در برابر موضوعات توهینآمیز کاهش تنش دهند و رشتههای پرخشونت را متوقف کنند

- چتباتهای عمومی در پلتفرمهای اجتماعی که ظرفیت معتدلسازی محدودی دارند

- دستیاران سازمانی که باید از محدودیتهای محتوایی قانونی و سیاستهای ایمنی داخلی پیروی کنند

محدودیتها و ملاحظات اخلاقی

خاتمهٔ یک چت یک تصمیم سیاسی است که توسط Anthropic اعمال شده و دلیلی بر آگاهی یا خودآگاهی ماشین نیست. مدلهای زبانی بزرگ سیستمهای آماری آموزشدیدهاند؛ رفتار کلود بازتاب آموزشهای همراستایی و محرکهای ایمنی طراحیشده است. ضروری است توسعهدهندگان موارد مثبت کاذب را زیرنظر داشته باشند، پیامرسانی شفاف به کاربران ارائه کنند و راههای بازگشت روشن وقتی جلسه بهاشتباه بسته شده فراهم نمایند.

نتیجهگیری

بهروزرسانی Anthropic یک لایهٔ ایمنی عملی و کمسختی به Claude Opus 4 و 4.1 اضافه میکند که به مدل توانایی خاتمهٔ جلسات در موارد سوءاستفادهٔ شدید و مکرر را میدهد. برای کسبوکارها و پلتفرمهایی که مدلهای زبانی را بهکار میگیرند، این ابزار میتواند در معتدلسازی محتوا و کاهش ریسک مفید باشد و حرکت گستردهتر صنعت بهسوی هوش مصنوعی اخلاقی، همراستایی مدل و سازوکارهای حفاظتی محکم در تعاملات گفتوگویی را تقویت کند.

منبع: lifehacker

ارسال نظر