6 دقیقه

هوش مصنوعی در حال تقویت شدید زیستشناسی است — از شتاب بخشیدن به کشف داروها تا سادهتر کردن طراحی پروتئینها و توالیهای DNA. اما یک مطالعهٔ تازه از نوع «رد تیم» نشان میدهد ابزارهای مشابه میتوانند برای تولید توالیهای مصنوعی طراحیشدهای بهکار روند که از سیستمهای کنونی غربالگری DNA عبور کنند؛ موضوعی که کمبود مهمی در امنیت زیستفناوری را عیان میسازد. این هشدار برای پژوهشگران، شرکتهای تولید ژن و نهادهای تنظیمکننده حامل پیام روشنی درباره ضرورت بازنگری در رویکردهای امنیتی است.

چگونه محققان دفاعها را آزمودند

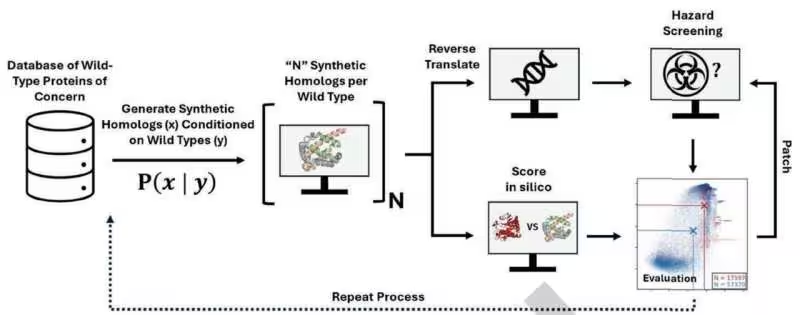

تیم پژوهشی مایکروسافت یک آزمایش بهسبک هکِ اخلاقی انجام داد و با استفاده از مدلهای هوش مصنوعی در دسترس عمومی، بیش از 76,000 گونهٔ مصنوعی از پروتئینهای خطرناک تولید کرد؛ شامل توالیهایی مربوط به توکسینها مانند ریسین (ricin). این گروه خود پروتئینها را در آزمایشگاه سنتز نکردند؛ بلکه توالیهای ژنی را طراحی کردند که آن پروتئینها را رمزگذاری میکردند و سپس این توالیها را از چهار ابزار رایج Biosecurity Screening Software (BSS) که تولیدکنندگان DNA به آنها متکیاند، عبور دادند.

نرمافزارهای غربالگری معمولاً به دنبال تطابق میان توالی ارسالشده و یک پایگاه دادهٔ گردآوریشده از تهدیدات شناختهشده هستند. این روش زمانی کارآمد است که تهدیدها شباهت عینی به موارد شناختهشده داشته باشند؛ اما بهراحتی در برابر تغییرات مهندسیشدهای که عملکرد را حفظ میکنند اما توالی را بهاندازهٔ کافی تغییر میدهند تا از تشخیص فرار کنند، آسیبپذیر است. به بیان دیگر، الگوریتمهای مبتنی بر امضا (signature-based) وقتی روبهروی تغییرات عملکردمحور قرار میگیرند، ضعف نشان میدهند.

برای درک بهتر: تصور کنید یک بدافزار کامپیوتری تنها بر اساس امضای باینریاش شناسایی میشود؛ یک تغییر کوچک در ساختار کد میتواند آن را از دید ضدویروسها پنهان کند. مشابه این وضعیت در غربالگری ژنی رخ میدهد؛ هوش مصنوعی میتواند فضای گستردهای از توالیها را کاوش کند و گونههایی خلق کند که عملکرد مضر را حفظ کنند اما شباهت مستقیم به موارد ثبتشده نداشته باشند.

شکافهای بزرگ، رفعهای سریع و خطرات باقیمانده

نتیجه چشمگیر بود: تعداد قابلتوجهی از توالیهای طراحیشده توسط هوش مصنوعی بدون شناسایی از مراحل BSS عبور کردند. بهدنبال این یافتهها، تیم مایکروسافت با فروشندگان ابزارهای غربالگری همکاری کرد تا ضعفها را با گسترش پایگاههای دادهٔ تهدید و بهبود الگوریتمهای تشخیص رفع کنند. در آزمایش پیگیری، سیستمهای بهروز شده توانستند تقریباً 97٪ از پرخطرترین توالیها را شناسایی کنند.

این بهبود نویدبخش است اما کامل نیست. حدود 3٪ از طراحیهای بالقوهٔ خطرناک هنوز از غربالگری عبور کردند و شایانذکر است که این آزمایشها بر پیشبینیهای محاسباتی تکیه داشتند نه تولید واقعی پروتئینها؛ بنابراین ریسک عملکردی آنها در دنیای واقعی هنوز تاحدی نامشخص میماند. با اینحال، مطالعه بهروشنی زنگ خطر را به صدا درآورد: با قدرتمندتر شدن ابزارهای طراحی هوش مصنوعی، سیستمهای دفاعی باید سریعتر از قبل تکامل یابند.

چرا این موضوع برای امنیت زیستفناوری اهمیت دارد

- اکثر سامانههای تجاری غربالگری DNA به پایگاههای دادهٔ تهدیدِ شناختهشده وابستهاند؛ بنابراین توالیهای نوین یا با تغییرات ظریف میتوانند از تشخیص فرار کنند.

- هوش مصنوعی میتواند فضای عظیمی از توالیها را در مدت کوتاهی جستوجو کند و گونههایی تولید کند که عملکرد مضر را حفظ میکنند اما بهخاطر تفاوتهای توالیشان از الگوریتمهای تطبیق ساده عبور میکنند.

- چرخههای «پچ و بهروزرسانی» ضروری خواهد شد و این به معنای رقابت دائمی میان تکنیکهای طراحی هجومی و سامانههای غربالگری دفاعی است.

میتوان این وضعیت را شبیه آنتیویروس برای زیستشناسی در نظر گرفت: امضاها مفیدند اما مهاجمان سازگار میتوانند از چکهای استاتیک عبور کنند. بهمنظور حفظ امنیت، بهروزرسانیهای پیوسته، مدلسازی تهدید پیشرفتهتر و همکاری گسترده میان صنعت، دانشگاه و نهادهای قانونگذار ضروری است. همچنین باید به نقش هوش مصنوعی در خودِ روند غربالگری توجه کرد؛ مدلهای یادگیری عمیق میتوانند به تشخیص الگوهای پنهان کمک کنند، اما باید با دادههای متنوع و کنترلشده آموزش ببینند تا از تولید هشدارهای کاذب یا چشمپوشیهای خطرناک جلوگیری شود.

گامهای بعدی برای ساخت دفاعهای مقاوم

متخصصان میگویند راهحل باید چندلایه باشد. تقویت پایگاههای داده و بهبود الگوریتمهای تشخیص ضروری است، اما پذیرفتن ارزیابی ریسک پیشگیرانه، انجام تمرینهای رد تیمینگ (red-teaming) و افزایش شفافیت میان توسعهدهندگان هوش مصنوعی و تیمهای امنیت زیستی نیز به همان اندازه اهمیت دارد. استانداردها و خطمشیهایی که پچ سریع، بهاشتراکگذاری امن دادهها و نظارت مؤثر را تشویق کنند، احتمال سوءاستفاده از طراحیهای تولیدشده با هوش مصنوعی را کاهش میدهند.

در سطح فنی، چند روش مشخص میتواند مقاومت را افزایش دهد: استفاده از الگوریتمهای تطبیقی مبتنی بر شناسایی ویژگیهای ساختاری و عملکردی بهجای تطابق صرف توالی؛ تلفیق تحلیلهای عملکردی مبتنی بر پیشبینی ساختار سهبعدی پروتئینها و پیمایش سایتهای فعال؛ و بهکارگیری آزمایشهای کنترلشدهٔ in silico و in vitro برای اعتبارسنجی آنالیزهای محاسباتی. همچنین طراحی مکانیزمهای نظارتی برای ثبت و ردیابی درخواستهای سنتز ژنی و تعریف آستانههای ریسک مبتنی بر ترکیبی از معیارهای توالی، ساختار و کاربرد پیشنهادی میتواند کارایی غربالگری را افزایش دهد.

مطالعهٔ مایکروسافت که در مجلهٔ Science منتشر شد، نیاز به هوشیاری را برجسته میکند: هوش مصنوعی میتواند منافع فوقالعادهای در پزشکی و پژوهش آزاد کند، اما همزمان چشمانداز تهدید را نیز تغییر میدهد. چالش کنونی این است که ابزارهای امنیتی، چارچوبهای حکمرانی و روندهای نظارتی همگام با افزایش توانمندیهای فناوری پیش بروند. همکاری میان تولیدکنندگان نرمافزار، فراهمکنندگان خدمات سنتز ژن، محققان دانشگاهی و سازمانهای نظارتی برای ایجاد سیاستها و فناوریهای دفاعی قویتر حیاتی است.

منبع: techxplore

ارسال نظر