8 دقیقه

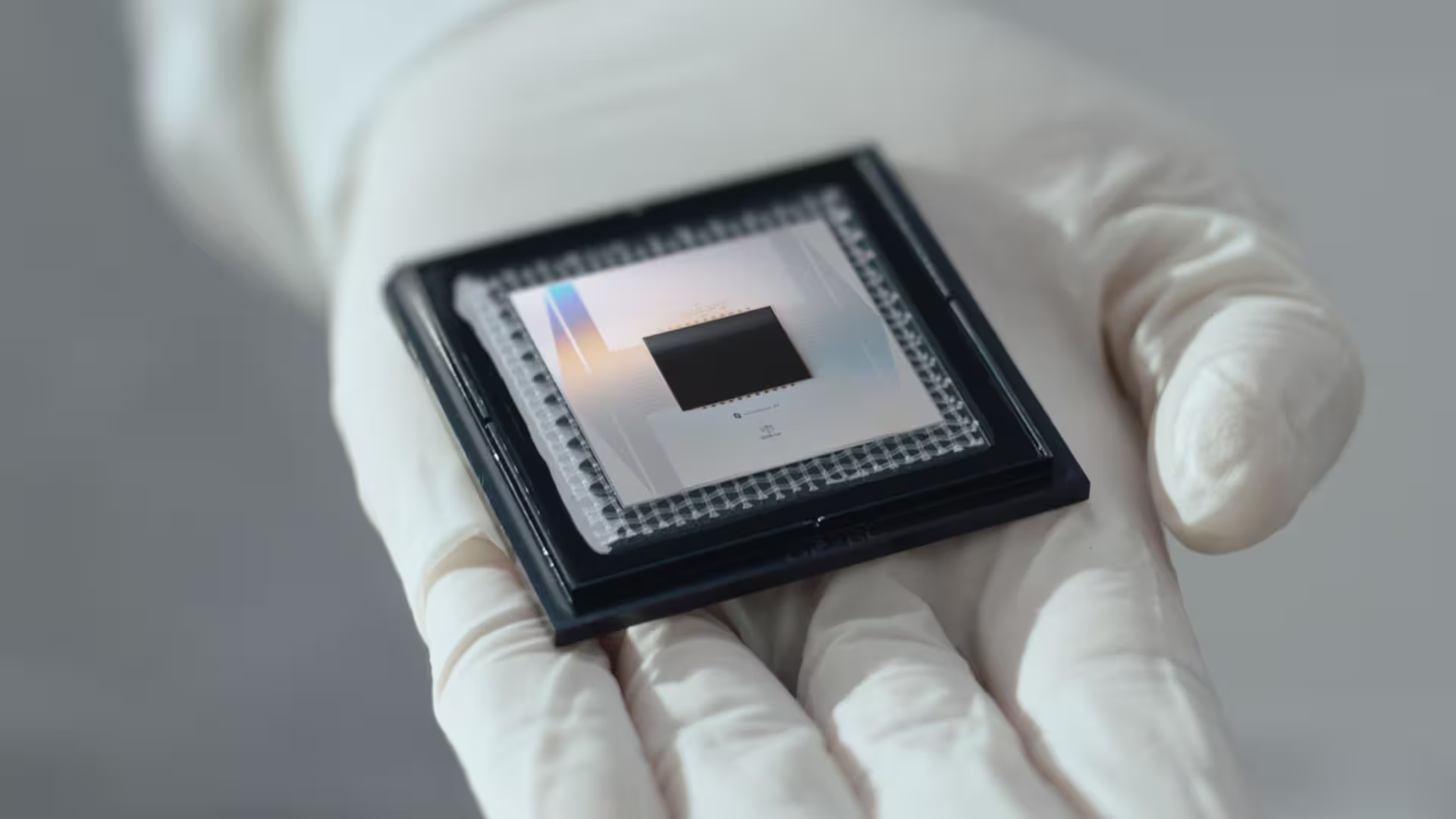

تیم هوش مصنوعی کوانتومی گوگل از پردازندهٔ ابررسانای ۱۰۵ کیوبیتی بهنام Willow رونمایی کرده است؛ سختافزاری که بهگفتهٔ این شرکت در برخی محاسبات مشخص حدود ۱۳۰۰۰ برابر از سریعترین ابررایانههای کلاسیک فعلی برتر عمل میکند. نتایج این کار در نشریهٔ Nature منتشر شده و آن را یکی از واضحترین نشانها از مزیت کوانتومی در یک آزمایش عملی گزارش میکنند.

فراتر از یک تیتر: ویلو دقیقاً چه کاری انجام داد

ویلو الگوریتم «Quantum Echoes» را اجرا کرد؛ الگوریتمی آزمایشی که برای بررسی آشوب کوانتومی و دینامیک پیچیدهٔ سامانههای چندجسمی کوانتومی طراحی شده است. برخلاف نمایش سال ۲۰۱۹ گوگل با پردازندهٔ Sycamore که یک وظیفهٔ نمونهبرداری تصادفی ویژه را هدف قرار داده بود، اجرای ویلو ارتباط مستقیمتری با کاربردهای علمی دارد؛ کاربردهایی مثل شبیهسازی ساختار مولکولی و تعاملات الکترونیکی با دقت بالاتر.

در سطح فنیتر، Quantum Echoes مجموعهای از سنجشها را شامل میشود که رفتار زمانی و همبستگی میان کیوبیتها را بررسی میکند و بهواسطهٔ آن میتوان پیچیدگی و رشد خطاها در مدارهای کوانتومی را تحلیل کرد. این نوع آزمونها برای سنجش قابلیت تولید نتایج قابلاعتبار و مقایسهٔ عملکرد سختافزار کوانتومی با الگوریتمهای شبیهسازی کلاسیک ضروری هستند.

بهگزارش تیم توسعه، هر یک از ۱۰۵ کیوبیت ابررسانای ویلو میتواند در حالات برهمنهی قرار گیرد و با دیگر کیوبیتها درهمتنیده شود، که این امکان را فراهم میآورد تا تراشه بهطورِ همزمان مجموعهٔ عظیمی از حالات ممکن را بررسی کند. سختافزار به نرخهای خطای بسیار پایین دست یافته است: فیدلیتی گیتهای تککیوبیتی حدود ۹۹.۹۷٪ و عملیات درهمتنیدهسازی دوکیوبیتی نزدیک به ۹۹.۸۸٪ گزارش شده است؛ مقادیری که برای محدود کردن خطاهای تجمعی در مدارهای گسترده حیاتی هستند.

این ارقام فیدلیتی، بهویژه در زمینهٔ شبیهسازی کوانتومی و الگوریتمهای حساس به خطا، نشان میدهند که تجهیزات ویلو قادر به حفظ انسجام کافی برای اجرای مدارهای با عمق منطقی نسبتاً بالا هستند. البته فیدلیتی تنها معیار نیست؛ پارامترهای دیگری مانند زمانهای کوهرنس (T1 و T2)، میزان کراستاک میان کانالها، و دقت کالیبراسیون نیز در تعیین کارایی کلی سیستم نقش دارند.

چرا پژوهشگران هیجانزدهاند (و محتاط)

میشل دوورِه، یکی از فیزیکدانان ارشد پروژه، پردازنده را شاهدی بر این دانست که مدارهای الکتریکی مهندسیشده میتوانند رفتار «اتمهای مصنوعی» را شبیهسازی کنند و آزمایشگاهی برای مطالعهٔ تعاملات در مقیاس اتمی فراهم آورند بدون آنکه مجبور باشیم به برخی تقریبهای مرسوم متوسل شویم. این ادعا فراتر از تبلیغات است: فیدلیتی بالاتر و درهمتنیدگی قویتر به دستگاههای کوانتومی امکان میدهد شبیهسازیهایی را اجرا کنند که سیستمهای کلاسیک بهسختی قادر به مدلسازی کارآمدشان هستند.

کاربردهای علمی و صنعتی

پیامدهای عملی میتواند چشمگیر باشد. شبیهسازیهای دقیقتر کوانتومی ممکن است سرعت کشف دارو را با مدلسازی واکنشهای شیمیایی بهصورت دقیقتر افزایش دهد؛ در پژوهش مواد برای باتریها یا اَبَررساناهای نسل بعدی کمک کند؛ و در نهایت برخی تسکهای بهینهسازی در هوش مصنوعی را با مصرف انرژی بسیار کمتر بهبود دهد. بهعبارتی، ویلو تنها یک بنچمارک نیست؛ بلکه نشانهای از جریان کاریهای دنیای واقعی است که ماشینهای کوانتومی میتوانند تحولشان دهند.

ملاحظات علمی و روششناختی

اعلان یک «مزیت کوانتومی» همیشه باید با دقت بررسی شود: لازم است روشهای ارزیابی، شیوههای اعتبارسنجی و مقایسهها با بهترین الگوریتمهای کلاسیک مستند و بازتولیدپذیر باشند. در مورد ویلو، انتشار در یک مجلهٔ همنقد (peer-reviewed) مانند Nature و ارائهٔ جزئیات تجربی و متدولوژی کمک میکند تا جامعهٔ علمی بتواند ادعاها را مستقل بررسی کند و نتایج را تکرار کند—از نکات کلیدی برای قبول گستردهٔ یک دستاورد علمی است.

از منظر نظری، تمایز میان اصطلاحات «مزیت کوانتومی» (quantum advantage) و «برتری کوانتومی» (quantum supremacy) اهمیت دارد: مزیت کوانتومی معمولاً به مواردی اطلاق میشود که کوانتومیها در کاربردهای مشخص و مفید بهتر از کلاسیکها عمل کنند؛ در حالی که برتری کوانتومی به برتری صرفاً محاسباتی در یک آزمون خاص و گاه غیرکاربردی اشاره دارد. ویلو در دستهٔ مزیت کوانتومی قرار میگیرد چون کاربردهای شبیهسازی علمی را هدف گرفته است.

موانع پیشرو

با وجود این دستاورد، موانع مهندسی عمدهای باقی ماندهاند. جامعهٔ علمی اتفاقنظر دارد که رفتن از کیوبیتهای فیزیکی پرنویز (noisy) به کیوبیتهای منطقی بزرگمقیاس و دارای تصحیح خطا، دشوارترین چالش پیشرو است. رشد مقیاس (scaling)، مدیریت حرارتی و معماریهای تحمل خطا (fault-tolerant) همه نیازمند پیشرفتهای بنیادین قبل از آناند که رایانههای کوانتومی به موتورهای عمومی تبدیل شوند.

برای درک بهتر، تصحیح خطا در رایانش کوانتومی مستلزم کدهای تصحیح خطا مانند surface code است که برای تولید یک کیوبیت منطقی نیاز به صدها یا هزاران کیوبیت فیزیکی دارد، بسته به نرخهای خطا و آستانهٔ عملیاتی. این افزایش تعداد کیوبیتها مستلزم طراحیهای جدید در زمینهٔ اتصالدهی، سیمکشیهای کریوژنیک، و کنترل الکترونیک روی و زیر صفحهٔ سرد (cold-control electronics) است. علاوه بر این، چالشهای عملی شامل کاهش کراستاک، افزایش زمانهای کوهرنس، و بهبود روشهای کالیبراسیون و مدیرت خطا در اجراهای بلندمدت است.

نیاز به پیشرفت در چند حوزه کلیدی

- تصحیح خطا و کیوبیتهای منطقی: توسعهٔ الگوریتمها و کدهایی که نسبت به خطا مقاومتر باشند و سربار منابع را کاهش دهند.

- خنکسازی و مدیریت حرارت: دیلزاسیون ریفریجریتورها، امپلیفایرهای پاییندمای کمنویز و طراحی مسیرهای حرارتی مناسب.

- الکترونیک کنترل و خوانش: یکپارچهسازی بیشتر بین کنترلرهای میکروویو و بوردهای سطح پایین تا کاهش کابلکشی و افزایش تعداد کانالها.

- معماری و اتصالدهی: طراحی شبکههای کیوبیتی با اتصال مناسب (connectivity) برای اجرای کارآمد الگوریتمهای شبیهسازی مولکولی و محاسبات کوانتومی عمومی.

علاوه بر اینها، مسائل اقتصادی و تولید صنعتی نیز اهمیت دارند: تولید پایدار کیوبیتهای با کیفیت بالا، تامین مواد و قطعات ابررسانا، و ایجاد زنجیرهٔ تامین برای رودخانهٔ توسعهٔ کوانتومی از چالشهای غیرفنی ولی تعیینکنندهاند.

با این حال، ویلو گامی معنادار است: یک آزمایش بازتولیدپذیر و مرورشده که نشان میدهد سختافزار قابلیت تولید نتایج قابلاعتبار و مفید را دارد. برای پژوهشگران و ناظران صنعتی، این نشاندهندهٔ انتقال پلتفرمهای کوانتومی از کنجکاویهای نظری به ابزارهای قابلاعتبار و ارزشافزا است.

دیدگاه رقابتی و موقعیت بازار

در میان بازیگران اصلی حوزهٔ رایانش کوانتومی—شامل شرکتهای تحقیقاتی و استارتاپها—تمرکز بر بهبود معیارهایی مانند حجم کوانتومی (quantum volume)، نرخ خطا، و تعداد کیوبیتها ادامه دارد. ویلو بهعنوان نقطهای در جدول زمانی توسعهٔ کوانتومی نقش دارد که میتواند معیار مقایسه برای دیگران شود. از منظر رقابتی، شرکتها ممکن است بر بهبود مشخصههایی که بیشترین تاثیر را بر کاربردهای صنعتی دارند، سرمایهگذاری کنند: شبیهسازی شیمیایی، بهینهسازی ترکیبی، و شتابدهی به مدلهای خاص در هوش مصنوعی کوانتومی.

چشمانداز علمی و پژوهشی

برای جامعهٔ علمی، اهمیت Willow در فراهمآوردن دادههای تجربی دقیق برای توسعهٔ مدلهای نظری و شبیهسازیهای تلفیقی (hybrid) است. پژوهشگران شیمی کوانتومی، فیزیک مادهٔ چگال، و علوم مواد میتوانند با دسترسی به نتایج شبیهسازیهای با فیدلیتی بالا، مدلهای بهتری از واکنشها و ساختارها ارائه دهند. همینطور کارشناسان الگوریتم کوانتومی میتوانند با دادههای واقعی روی سختافزار، الگوریتمهای مقاومتر و قابلاجرا طراحی کنند.

در مجموع، ویلو نمایانگر پلی است میان پیشرفتهای سختافزاری—مانند طراحیهای تراشه و بهینهسازی گیتها—و نیازهای کاربردی دنیای واقعی در علوم و صنعت. این نوع پیشرفتها به تقویت اکوسیستم توسعهٔ نرمافزار کوانتومی و ابزارهای شبیهسازی نیز کمک میکنند.

برای علاقهمندان به مباحث فنی، جزئیات عملیاتی بیشتر شامل اطلاعاتی دربارهٔ توپوگرافی کیوبیتها، نوع کیوبیتهای ابررسانا (مثلاً ترانزونها و اتصالات جوزفسون)، و روشهای اندازهگیری و خوانش کوانتومی است که در مقالات فنی همراه با دادههای تجربی منتشر میشوند. بررسی این جزئیات میتواند به توسعهٔ بهینهسازیهای سطح پایین و روشهای کالیبراسیون بهبود یافته بینجامد.

در نهایت، هرچند ویلو نشاندهندهٔ پیشرفتی مهم است، مسیر تا رسیدن به رایانش کوانتومی عمومی و متداول هنوز طولانی است و نیاز به تلاشهای هماهنگ در سطوح تحقیق، مهندسی و سرمایهگذاری دارد. اما این نتیجه بهروشنی نشان میدهد که زمینهٔ رایانش کوانتومی از مرحلهٔ کنجکاوی علمی فراتر رفته و به مرحلهای نزدیکتر به کاربردهای صنعتی و علمی وارد شده است.

منبع: gizmochina

نظرات

نووا_م

یکم هایپ داره، خب پیشرفت مهمه اما تا رایانش کوانتومی عمومی راه طولانیه؛ تبلیغات نباید جای منطق رو بگیره

پمپزون

خوندن این گزارش یاد لاب خودمون انداخت، فیدلیتی بالا یعنی امید ولی کابلکشی، کنترل و خنکسازی رو نادیده نگیرید، تجربهٔ شخصیام اینه که مهندسیاش همیشه دردسره

مهدی

نشر در Nature قوت داره ولی سوال اینه که رقابت با بهترین کلاسیکها چطور انجام شد؟ آیا همه چیز شفاف منتشر شده؟

لابنیکس

فیدلیتیها عالیه، شبیهسازی علمی مفیدتر از نمونهبرداری تصادفی، امیدوارم به کاربردهای واقعی برسه

رودکس

۱۳۰۰۰ برابر؟! واقعا میشه؟ هیجانانگیزه اما یه حس احتیاط هم هست، باید نتایج بازتولید بشن و بس — اوه صبر...

ارسال نظر