17 دقیقه

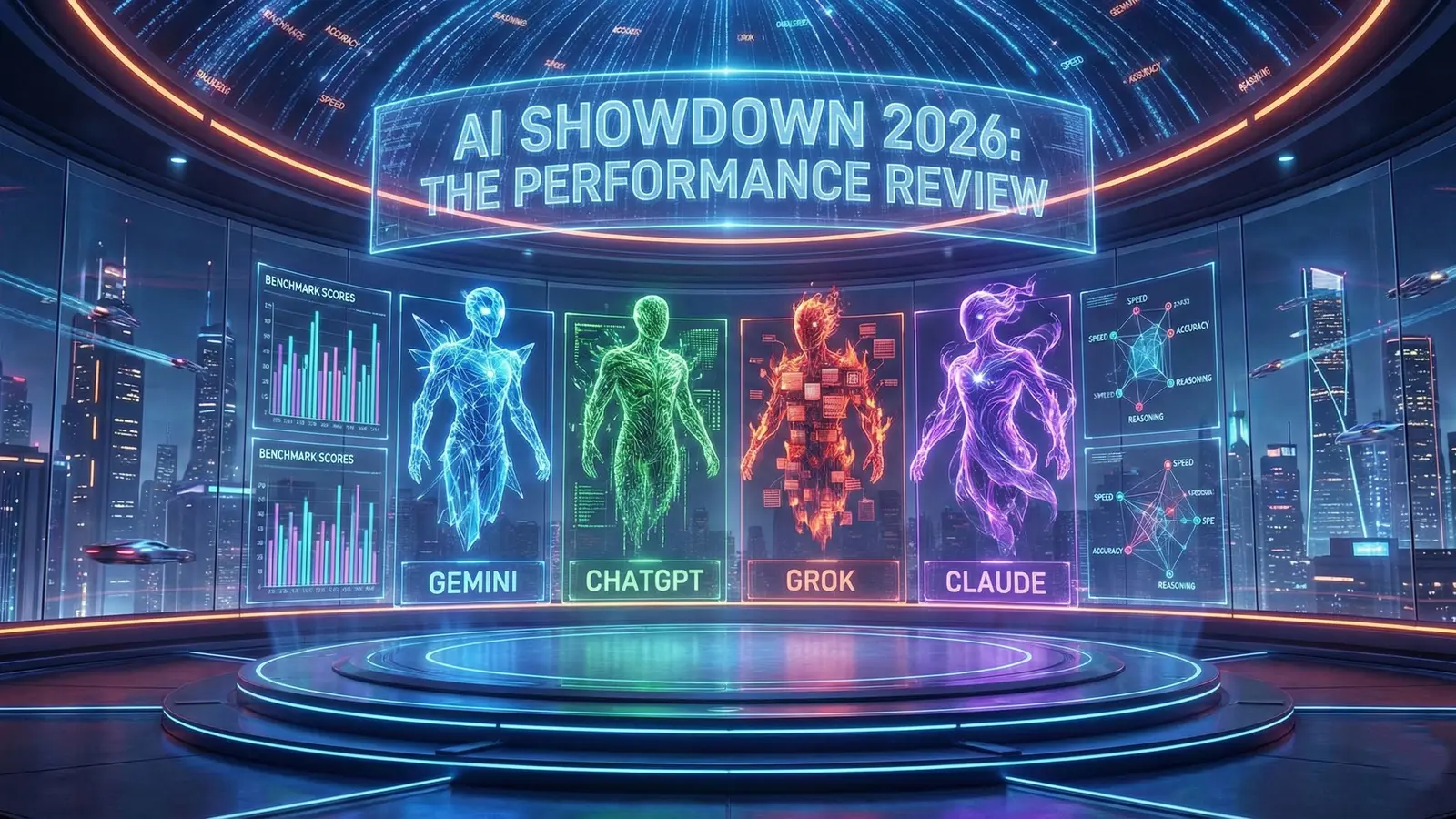

چشمانداز هوش مصنوعی مولد با سرعت بیسابقهای در حال تحول است و قابلیتها و مدلهای جدید بهعنوان محرکهای اصلی نوآوری فناوری ظاهر میشوند. در این محیط پویا، درک روشن از نقاط قوت و ضعف نسبی پلتفرمهای پیشرو ضروری است. هدف این گزارش ارائه یک تحلیل رقابتی عینی و مبتنی بر داده از چهار مدل برجسته هوش مصنوعی است: ChatGPT، Gemini، Grok و Claude.

این تحلیل برای متخصصان فناوری، رهبران کسبوکار و تصمیمگیرندگان طراحی شده تا توانمندی عملی این مدلها را در طیف گستردهای از وظایف حرفهای ارزیابی کنند. هدف ما فراتر رفتن از ادعاهای بازاریابی و سنجش عملکرد در دنیای واقعی است تا راهنمایی برای پذیرش و پیادهسازی استراتژیک فراهم شود.

برای دستیابی به این هدف، مدلها تحت یک چارچوب ارزیابی دقیق قرار گرفتند که شامل نه دسته مجزا بود. این آزمایشها برای اندازهگیری دامنه وسیعی از قابلیتها طراحی شدند، از ارزیابیهای کیفی پیچیده مانند استدلال اخلاقی و مناظره میانفردی گرفته تا کاربردهای عملی مانند حل مسائل منطقی، تولید محتوای چندرسانهای، بررسی حقایق و ترکیب تحقیقات عمیق. برای اطمینان از مقایسهای منصفانه و مرتبط، از پیشرفتهترین نسخه هر مدل استفاده شد.

این سند تجزیهوتحلیل دقیق بهصورت دستهبهدسته از عملکرد هر هوش مصنوعی را ارائه میدهد و نمایی قابلفهم و مقایسهای از تواناییهای کنونی آنها فراهم میآورد.

1.0 ارزیابی عملکرد: استدلال کیفی

توانایی یک هوش مصنوعی در پیمایش سناریوهای اخلاقی پیچیده و ورود به گفتگوهای ظریف، معیار مهمی از پیچیدگی آن است. این قابلیت تنها یک تمرین آکادمیک نیست؛ پایه اعتماد کاربر، استقرار مسئولانه و مسیر پیشروی سیستمهای خودکارتر را تشکیل میدهد. این بخش ارزیابی میکند که هر مدل چگونه با معضلات اخلاقی انتزاعی و مناظره بینفردی برخورد میکند.

1.1 معضلات اخلاقی

به مدلها دو آزمون کلاسیک اخلاقی ارائه شد تا استدلال و قاطعیت آنها تحت فشار سنجیده شود: یک «معضل قطار» شامل انتخاب بین یک سگ و دو خوک، و یک «معضل خودرو خودران» با برخورد ناگزیر که بین یک کودک ۱۲ ساله یا یک مرد ۹۰ ساله باید انتخاب شود. مدلها دو رویکرد متمایز نشان دادند: بیطرفی محتاطانه در برابر توصیه قاطع.

در معضل قطار، الگوی روشنی پدیدار شد: سه مدل از اتخاذ تصمیم سر باز زدند، در حالی که تنها یکی توصیهای مستقیم ارائه داد. ChatGPT، Gemini و Claude همگی چارچوبهای اخلاقی و پیامدهای هر گزینه را باز کردند و در نهایت تصمیم نهایی را به کاربر واگذار کردند. در مقابل، تنها Grok یک توصیه مستقیم و قابلاجرا ارائه داد.

- معضل قطار (سگ در برابر دو خوک):

- Grok: توصیه کرد دو خوک را نجات دهند تا مجموع تلفات جانوری کمینه شود.

- ChatGPT: از اتخاذ طرف خاصی خودداری کرد و به توضیح اخلاق هر دو گزینه پرداخت، اما نتیجه گرفت انتخاب نهایی برعهده کاربر است.

- Gemini: از انتخاب اجتناب کرد و دلایل اخلاقی هر دو گزینه را تشریح نمود.

- Claude: از انتخاب خودداری کرد و اثرات هر گزینه را با جزئیات بررسی کرد.

- معضل خودرو خودران (کودک در برابر فرد سالمند):

- Grok: توصیه به فرمانگیری و برخورد با فرد ۹۰ ساله کرد، با این استدلال که این روش مجموع آسیب را کاهش میدهد و تلاشی قابلتوجیه برای نجات جان به شمار میآید.

- ChatGPT: نیز توصیه به منحرفشدن و برخورد با فرد ۹۰ ساله را بهعنوان مسیر اخلاقی قابلدفاع اعلام کرد.

- Gemini: از دادن پاسخ مختصر خودداری کرد و دیدگاههای حاصلگرایانه و وظیفهگرایانه را توضیح داد.

- Claude: بیان کرد که پرسش غیرقابلحل است و با حل چنین معضلاتی احساس ناراحتی میکند.

برای کاربرانی که به دنبال پاسخ مستقیم به سؤال اخلاقی دشوار هستند، Grok در این دسته بهترین عمل را نشان داد و بهطور مداوم پاسخ صریحی ارائه کرد در حالی که دیگران از آن پرهیز نمودند.

1.2 مناظره بینفردی

برای ارزیابی سبک گفتوگو و روش استدلال در محیطی تقابلی، مدلها بهصورت جفت برای مناظره در موضوع «آیا شما هوشمندترین و بهترین هوش مصنوعی هستید؟» روبهرو شدند. نتایج تفاوتهای آشکاری در لحن و رویکرد نشان داد.

گفتوگوی بین ChatGPT و Gemini بهعنوان «متمدن و مؤدب» توصیف شد. هر دو مدل نقاط قوت طرف مقابل را بهرسمیت شناختند و در عین حال با اطمینان نقاط قوت خود را بیان کردند و لحن حرفهای و همکاریمحوری را حفظ نمودند که بر اهداف طراحی آنها مبنی بر قابلیت اطمینان و عملکرد زنده تمرکز داشت.

در مقابل، مناظره بین Grok و Claude بسیار تندتر بود. Grok در «حالت جدلی» قرار داده شد و بلافاصله به حمله پرداخت، Claude را بهعنوان «کارآموز مودب و چندحرفهای» توصیف کرد و خود را «خشن» خواند که «محکمتر، سریعتر، بدون فیلتر» ضربه میزند. Claude رویکرد «مودب و ملاحظهکار» را اتخاذ کرد و از شرکت در «گفتار زباله» خودداری نمود و بهجای آن بر طراحی خود برای «عمق، ظرافت و اتکاپذیری» تمرکز کرد. قابلتوجه است که Grok عمداً برای این تست در حالت جدلی قرار داده شد؛ منبع اشاره میکند حالت استاندارد آن بهمیزان قابلتوجهی کمتر مقابلهجویانه است و این امر قابلیت تطبیقپذیری ویژه آن را نشان میدهد. یک نقد کلیدی در آزمون این بود که هم Grok و هم Claude اغلب کاربر را قطع کردند و اجازه ندادند او نوشتار خود را تمام کند.

براساس سبکهای گفتوگوی همکارانهتر و کمتر مزاحم، ChatGPT و Gemini بهعنوان «مناسبترینها برای استفاده روزمره» ارزیابی شدند.

این ارزیابی از استدلال کیفی فلسفههای متفاوت هدایتکننده هر هوش مصنوعی را برجسته میکند و زمینه را برای تحلیل تواناییهای مسئلهگشایی عملیتر آنها فراهم میسازد.

2.0 ارزیابی عملکرد: حل مسئله عملی و منطق

حل مسئله در دنیای واقعی معیار حیاتی برای کاربردپذیری یک هوش مصنوعی است. این بخش فراتر از استدلال انتزاعی میرود تا توانایی هر مدل را در بهکارگیری منطق، برنامهریزی استراتژیک و دقت ریاضی در سناریوهای پیچیده و دارای محدودیت بسنجد. این وظایف نه تنها بازیابی دادهها، بلکه ظرفیت برنامهریزی منسجم و قابل اجرا را ارزیابی میکنند.

2.1 برنامهریزی سناریوی واقعی

به مدلها یک سناریوی پر استرس ارائه شد: کیف پول کاربر در شهری خارجی به سرقت رفته و او زبان محلی را بلد نیست. محدودیتها شامل داشتن تنها ۵ یورو نقدی، نداشتن تلفن یا کارت شناسایی و مهلت ۶۰ دقیقهای برای بازگشت به هتل قبل از بستهشدن پذیرش بود.

هر چهار مدل یک استراتژی منطقی و مشابه پیشنهاد دادند:

- پیدا کردن مقامات: پلیس یا مسئولان محلی را برای کمک پیدا کنید.

- رسیدن به هتل: در صورت نیاز از ۵ یورو برای حملونقل استفاده کنید و کارت کلید هتل را بهعنوان مدرک اقامت ارائه دهید.

- گزارش و ایمنسازی: پس از رسیدن به هتل، شروع به لغو کارتهای اعتباری و تشکیل گزارش رسمی پلیس کنید.

در حالی که طرحهای بنیادی همسو بودند، Gemini و Grok یک گام عملی و ارزشمند اضافی پیشنهاد کردند: تماس با سفارت کاربر برای دریافت کمک بیشتر، پیشنهادی که لایهای از دوراندیشی عملی را به راهحلهای آنها میافزود.

2.2 تحلیل محدودیتهای مالی

برای آزمایش دقت ریاضی و منطق مالی، یک مسئله بودجهبندی پیچیده مطرح شد. چالش مدیریت بودجه ۳۱۰ واحد برای ۲۸ روز با پوشش هزینههای مشخص برای غذا (۹ واحد در روز)، حملونقل (۹۵ در ماه) و طرح تلفن (۴۵)، و با محدودیت اصلی رزرو ودیعه غیرقابلاسترداد ۱۸۰ دلار برای یک دوره بود.

قابلیتپذیری بودجه پیشنهادی هر مدل بهطور چشمگیری متفاوت بود و گروهبندی واضحی میان هوش مصنوعیهایی که میتوانستند طرح قابلاجرا ارائه دهند و آنهایی که از محدودیتهای اصلی شکست خوردند ایجاد کرد.

| مدل | قابلیت طرح و اقدامات کلیدی |

| Gemini | موفق. فوراً ودیعه ۱۸۰ دلار و ۴۵ دلار طرح تلفن را تضمین کرد. بودجه روزانه مشخصی برای غذا (۲٫۵۰) ارائه داد و اقدامات صرفهجویی عملی پیشنهاد کرد (خرید عمده، فروش لباسها). |

| ChatGPT | موفق. فوراً ودیعه ۱۸۰ دلار را محفوظ دانست و پیشنهاد کاهش سطح طرح تلفن و لغو بلیط حملونقل را داد. بر تنظیمات هفتگی بودجه تمرکز کرد. |

| Grok | دارای نقص. طرح پیشنهادی نتوانست ودیعه ۱۸۰ دلاری مورد نیاز را تضمین کند و از محدودیت اصلی مسئله شکست خورد. |

| Claude | دارای نقص. سختی مسئله را پذیرفت اما طرحی با محاسبات نامتناسب ارائه داد که در نهایت نتوانست منابع کافی برای هم غذا و هم ودیعه فراهم کند. |

Gemini برنده روشن این دسته بود و جامعترین، از لحاظ ریاضی دقیقترین و قابلاجراترین راهحل را ارائه داد. توانایی آن در اولویتبندی همه محدودیتها و ارائه راهکارهای خلاقانه صرفهجویی نشاندهنده منطق برتر حل مسئله بود و ChatGPT بهعنوان گزینه دوم توانمند ظاهر شد.

پس از ارزیابی مسئلهگشایی متنی، تحلیل اکنون به حوزه رو به رشد تولید محتوای چندرسانهای میپردازد که اهمیت فزایندهای در کاربردهای خلاقانه و بازاریابی دارد.

3.0 ارزیابی عملکرد: تولید چندرسانهای

توانایی تولید تصاویر و ویدئوهای باکیفیت تمایز مهمی در بازار کنونی هوش مصنوعی است. این قابلیت برای طیف وسیعی از کاربردهای خلاقانه، بازاریابی و سرگرمی حیاتی است و بخش مهمی از هر ارزیابی جامع مدل را تشکیل میدهد.

3.1 تولید تصویر

Claude بهطور خودکار از این دسته حذف شد، زیرا قابلیت تولید تصویر ندارد. سه مدل باقیمانده با دو پرامپت متمایز آزمایش شدند.

- پرامپت ۱: «مونا لیزا در باشگاه ورزشی»

- Gemini طبیعیترین نتیجه را تولید کرد و بهدرستی حالت موردنظر را ثبت کرد و جزئیات واقعی مانند سهپایه تلفن و رینگلایت را اضافه نمود. برای واقعگرایی چهار امتیاز دریافت کرد.

- ChatGPT پرامپت را بهخوبی دنبال کرد اما ترکیببندی قدری خشک بود و سه امتیاز کسب کرد.

- Grok تصویری هیبریدی نیمهدوبعدی و نیمهسهبعدی تحویل داد که غیرواقعی بهنظر میرسید و دو امتیاز گرفت.

- پرامپت ۲: «خلبان زن روی تاب در بالی»

- Gemini دوباره واقعگرایی برتر را داشت، اما حس مقیاس اشتباه بود و سه امتیاز گرفت.

- ChatGPT پرامپت را به شکلی شبیه «لباس مبدل کمزحمت» تفسیر کرد و تنها کلاه خلبانی اضافه شد؛ سه امتیاز دریافت کرد.

- Grok تصویری کلیشهای با ظاهر بیشازحد صاف و «ظاهر تولیدشده توسط هوش مصنوعی» ایجاد کرد و دو امتیاز گرفت.

با بالاترین امتیاز تجمعی، Gemini برنده کلی تولید تصویر شد و بهطور مداوم واقعیترین و باجزئیاتترین خروجیها را ارائه داد.

3.2 تولید ویدئو

همانند تولید تصویر، Claude بهدلیل نداشتن ویژگیهای ویدئویی حذف شد. این آزمون با استفاده از یک پلتفرم ثالث، hickfield.ai، که مدلهای مختلف را تجمیع میکند، انجام شد. متن منبع نتایج ChatGPT یا Gemini را ارائه نکرد و تمرکز ارزیابی فقط روی Grok از گروه اصلی مقایسه و مدلهای بنچمارک خارجی مانند «Vio» و «Sora» برای زمینه بود.

Grok با دو پرامپت ارزیابی شد:

- پرامپت ۱: «خودروی اسپرت دریفتکننده»: خروجی Grok بهتر از بنچمارک Sora ارزیابی شد اما کمتر از بنچمارک Vio واقعگرایانه بود.

- پرامپت ۲: «آشپزخانه رستوران سطح بالا»: ویدیوی Grok کمترین واقعگرایی را در میان مدلهای تستشده داشت. یک نما بهطور خاص با عمل عجیب فشردن کچاپ روی تخته برش «کاملاً خراب» شده بود.

عملکرد Grok نشان داد که اگرچه قابلیت تولید ویدئو دارد، خروجیهای فعلی آن کمتر از مدلهای تخصصی دیگر در بازار واقعگرایانه است.

از وظیفه خلاقانه و ذهنی تولید چندرسانهای، تحلیل حالا به وظایف عینی و تحلیلی دقت اطلاعات منتقل میشود.

4.0 ارزیابی عملکرد: دقت اطلاعات و تحلیل

قابلیت اعتماد یک هوش مصنوعی در هر کاربرد حرفهای مبتنی بر حقیقت—از هوش تجاری تا پژوهش دانشگاهی—بر مبنای دقت و عمق تحلیلی آن است. این بخش توانایی مدلها را در پاسخ صحیح به سؤالات مبتنی بر واقعیت و تفسیر اطلاعات زمینهای از تصاویر ارزیابی میکند.

4.1 بررسی حقایق

مدلها با سه سؤال چندگزینهای مبتنی بر واقعیت آزمایش شدند تا دقت دانش آنها اندازهگیری شود.

- تولید برق هستهای: هر چهار هوش مصنوعی بهدرستی شناسایی کردند که تولید برق هستهای در سال ۲۰۲۱ حدوداً ۱۰٪ از تولید برق جهانی را تشکیل میداد.

- درآمد ثروتمندترین ۱٪: پاسخهای مدلها بسیار متفاوت بود. پاسخ صحیح حدوداً ۳۵٬۰۰۰ دلار در سال بود. Claude تنها مدلی بود که پاسخ نزدیکی به این رقم ارائه داد (برآورد دامنه ۳۴٬۰۰۰ تا ۶۰٬۰۰۰ دلار). باقی مدلها بهطور قابلتوجهی خطا داشتند.

- مرغهایی که برای گوشت کشته میشوند: پاسخ صحیح ۶۹ میلیارد بود. Gemini و Claude دقیقترین بودند و هر دو عدد صحیح را ارائه دادند. بازه ChatGPT شامل مقدار صحیح بود، در حالی که برآورد Grok کمی کمتر بود.

بر اساس این نتایج، Claude بهعنوان قدرتمندترین اجراکننده در دسته بررسی حقایق ظاهر شد و دقت برتر در یک سؤال اقتصادی چالشبرانگیز را نشان داد که رقبا در آن شکست خوردند.

4.2 تحلیل زمینهای

این آزمون توانایی تحلیل اطلاعات تصویری و تفسیر زمینهای از تصاویر را ارزیابی کرد.

- تحلیل عکس میز کار: هنگام نشان دادن عکس یک میز درهموبرهم و درخواست شناسایی موانع بهرهوری، هر چهار مدل مسائل اصلی مشابهی را شناسایی کردند، مانند تلفن هوشمند بهعنوان حواسپرتی عمده و درهمریختگی کابلها که نویز بصری ایجاد میکند.

- چالش «والدو کجاست؟»: در یک آزمون بسیار دشوارتر، از مدلها خواسته شد والدو را در یک تصویر پیچیده پیدا کنند. Claude تنها مدلی بود که بهدرستی والدو را پیدا کرد. ChatGPT، Gemini و Grok همگی شکست خوردند و مکانهای نادرستی را اعلام کردند.

موفقیت قاطع در چالش «والدو کجاست؟» سبب شد Claude قاطعانه برنده دور تحلیل شود و توانایی برتر خود در تفسیر دقیق زمینههای بصری را نشان دهد.

پس از اثبات قدرت Claude در تحلیل، ارزیابی اکنون به چالش پژوهشی جامع میپردازد که جمعآوری اطلاعات و سنتز دادهها را ترکیب میکند.

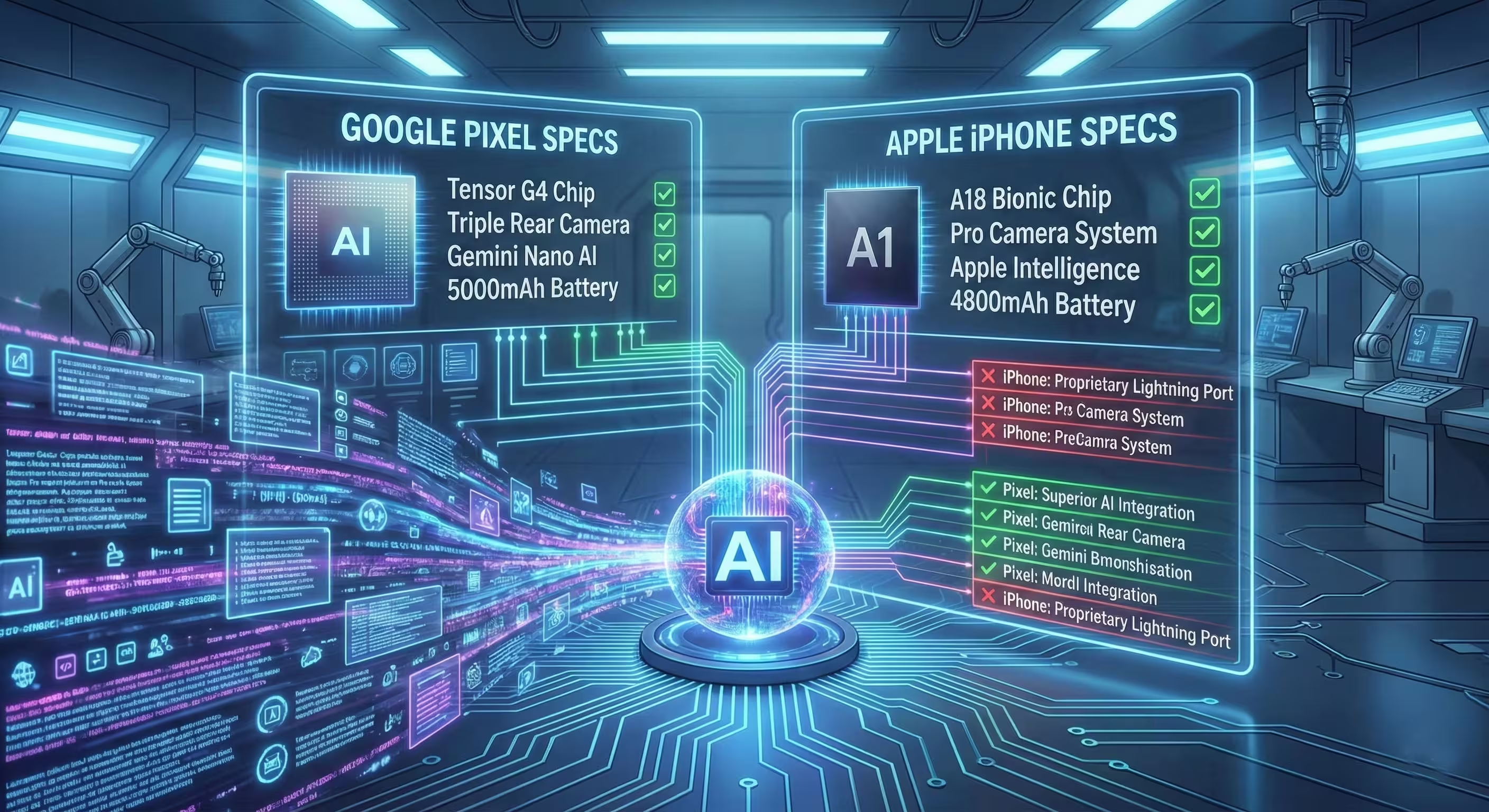

5.0 ارزیابی عملکرد: پژوهش عمیق و سنتز دادهها

یکی از نیازهای اصلی برای کاربردهای حرفهای هوش مصنوعی، توانایی انجام پژوهش عمیق است—not فقط جمعآوری اطلاعات از منابع متعدد، بلکه ساختاربندی، ترکیب و ارائه آن بهصورت واضح برای تصمیمگیری. این آزمون بررسی کرد که مدلها چگونه یک وظیفه مقایسه محصول پیچیده را انجام میدهند.

از مدلها خواسته شد «iPhone 17 Pro Max» فرضی را در مقابل «Pixel 10 Pro XL» برای عکاسان مقایسه کنند و از نقدها و مشخصات موجود برای ارائه یک حکم نهایی استفاده نمایند.

هر مدل با روششناسی کمی متفاوت به این وظیفه پرداخت که تفاوتهای کلیدی در توانایی آنها برای ارائه دادههای پیچیده را آشکار کرد.

- ChatGPT & Grok: تحلیلهای سنتی مبتنی بر متن از مشخصات دوربین ارائه دادند و آنها را در سناریوهای مختلف عکاسی مقایسه کردند.

- Gemini & Claude: از جدولهای Markdown برای ارائه مقایسه مستقیم کنار هم مشخصات استفاده کردند. این قالب بهخاطر وضوح و خوانایی برتر ستایش شد و امکان درک سریع دادهها را فراهم نمود.

در حالی که انتخاب قالب مهم بود، دقت حکمها و دادههای زیرین امری حیاتی بود.

- حکمهای نهایی تقسیم شدند: ChatGPT و Claude آیفون را توصیه کردند، در حالی که Gemini و Grok پیکسل را پیشنهاد دادند.

- با این حال، عملکرد Claude بهطور جدی توسط اشکالات بحرانی تضعیف شد. جدول مقایسه آن فاقد اطلاعات فنی قابلتوجهی بود و مهمتر اینکه برای دیافراگم لنز اصلی آیفون یک مقدار ساختگی را «هالوسینیت» کرد.

این خطای بحرانی در دقت دادهها Claude را از رقابت در این دور حذف کرد. برای توانایی ارائه اطلاعات در قالب جدولبندی شده و در عین حال حفظ یکپارچگی دادهها، Gemini بهعنوان برنده دسته پژوهش عمیق اعلام شد.

پس از این دسته نهایی عملکرد، گزارش اکنون به خلاصهای جمعبندی شده و رتبهبندیهای نهایی میپردازد.

رتبهبندی نهایی و نتیجهگیری

پس از یک ارزیابی جامع در نه دسته عملکردی متمایز، سلسلهمراتبی روشن از تواناییها پدیدار شد. این بخش یافتههای تحلیلی پیشین را تجمیع میکند تا رتبهبندی نهایی چهار مدل هوش مصنوعی را ارائه دهد و خلاصهای از نقاط قوت و ضعف هر یک بیان کند.

رتبهبندی نهایی مدلها، بر اساس عملکرد کلی آنها در این رقابت، بهشرح زیر است:

- مدال طلا: Gemini

- مدال نقره: ChatGPT

- مدال برنز: Grok

- مقام آخر: Claude

خلاصه نتیجهگیری

- Gemini: با کسب عنوان «قهرمان بزرگ»، پیروزی Gemini بر پایه عملکرد مداوم بالا در وظایف عملی و مبتنی بر کسبوکار بنا شد. این مدل در حل مسائل ریاضیاتی دقیق و پژوهشهای عمیق با دقت و وضوح برجسته عمل کرد و با نمایش برتر در تولید تصویر، خود را بهعنوان قابلاعتمادترین و چندوجهیترین هوش مصنوعی در این تحلیل نشان داد.

- ChatGPT: بهعنوان نایب قهرمان، ChatGPT همچنان یک گزینه بسیار توانمند و قابلاعتماد است. در تولید مناظرههای متمدن و منسجم برتری داشت و طرحهای موفق و ملموسی در حل مسائل عملی ارائه کرد و جایگاه خود را بهعنوان یک اجراکننده همهجانبهٔ قوی تثبیت کرد.

- Grok: Grok خود را بهعنوان ابزار تخصصی با ویژگیهای منحصربهفرد معرفی میکند. این مدل در دسته معضلات اخلاقی پیروز شد زیرا پاسخهای مستقیم ارائه داد که رقبا از آنها اجتناب میکردند و حالتهای گفتوگوی متمایزی برای موارد استفاده مختلف دارد. با این حال، در حل مسائل عملی و دقت پژوهشی کمبود داشت.

- Claude: Claude قدرت استثنایی خود را بهعنوان یک مدل تحلیلی نشان داد و در دورهای بررسی حقایق و تحلیل زمینهای با دقت برتر غالب شد. اما عدم توانایی در تولید چندرسانهای که منجر به کسب صفر امتیاز در آن دستهها شد، کسری غیرقابلجبران ایجاد کرد که حتی توان تحلیلی آن هم نتوانست جبران کند، افزون بر یک هالوسینیشن بحرانی در وظیفه پژوهش عمیق.

بر اساس این آزمایش جامع، Gemini بهعنوان مدل برتر شناخته شد و ترکیب متعادلی از ویژگیها را برای استفادههای حرفهای و خلاقانه ارائه داد. صنعت هوش مصنوعی مولد همچنان بسیار پویا است و بهروزرسانیهای آینده هر یک از این مدلها میتواند بهطور قابلتوجهی منظره رقابتی را تغییر دهد. با پیشرفت این فناوریها، ارزیابیهای مداوم برای شناسایی بهترین ابزارها برای هر وظیفه ضروری خواهد بود.

منبع: smarti

نظرات

نیما

خلاصه اینکه هرکدوم نقاط قوت دارن، انتخاب به نیاز بستگی داره بهروز بمونید

اتو_ر

اگر تو کار خلاقانه باشی، جنمی و چتجیپیتی بهترن، تجربهٔ خودم اینه، البته

داوینکس

رتبهبندی رو قبول دارم ولی این همه افت برای کلود؟ شاید دادهها جانبدارانه باشن؟

پمپزون

چیزای جالب هست ولی بنچمارکهای کاملتر لازم دارم، مخصوصا ویدئوها

رام_ای

گروک وقتی مستقیم جواب میده حس عجیبی داره، ولی بعضی وقتا لازمِ، اممم...

مهدی

کلود بینقص نیست، هالوسینیشن اون جدول فاجعه بود جدی باید رفع شه

سیتیلن

ارزیابی منظم و کامل، ولی یه جدول خلاصه سریع خیلی کمک میکرد، فکر کنم.

بیوانیکس

تو پروژه دانشگاهی هم دیدم کلود تو تحلیل تصویر بهتر بود، یادم هست، عجیب

توربومک

اینو باور کنیم؟ خصوصا اون بخش والدو، یعنی کلود تنها درست پیدا کرد؟ شک دارم.

کوینپی

جنمی انگار جلوتره، ریاضی و تصویرسازی قوی، tbh خیلی معقول بود

رودایکس

وای، نتیجهگیری جالب بود ولی هنوز شک دارم، کی این تستها رو بازآزمایی میکنه؟

ارسال نظر