9 دقیقه

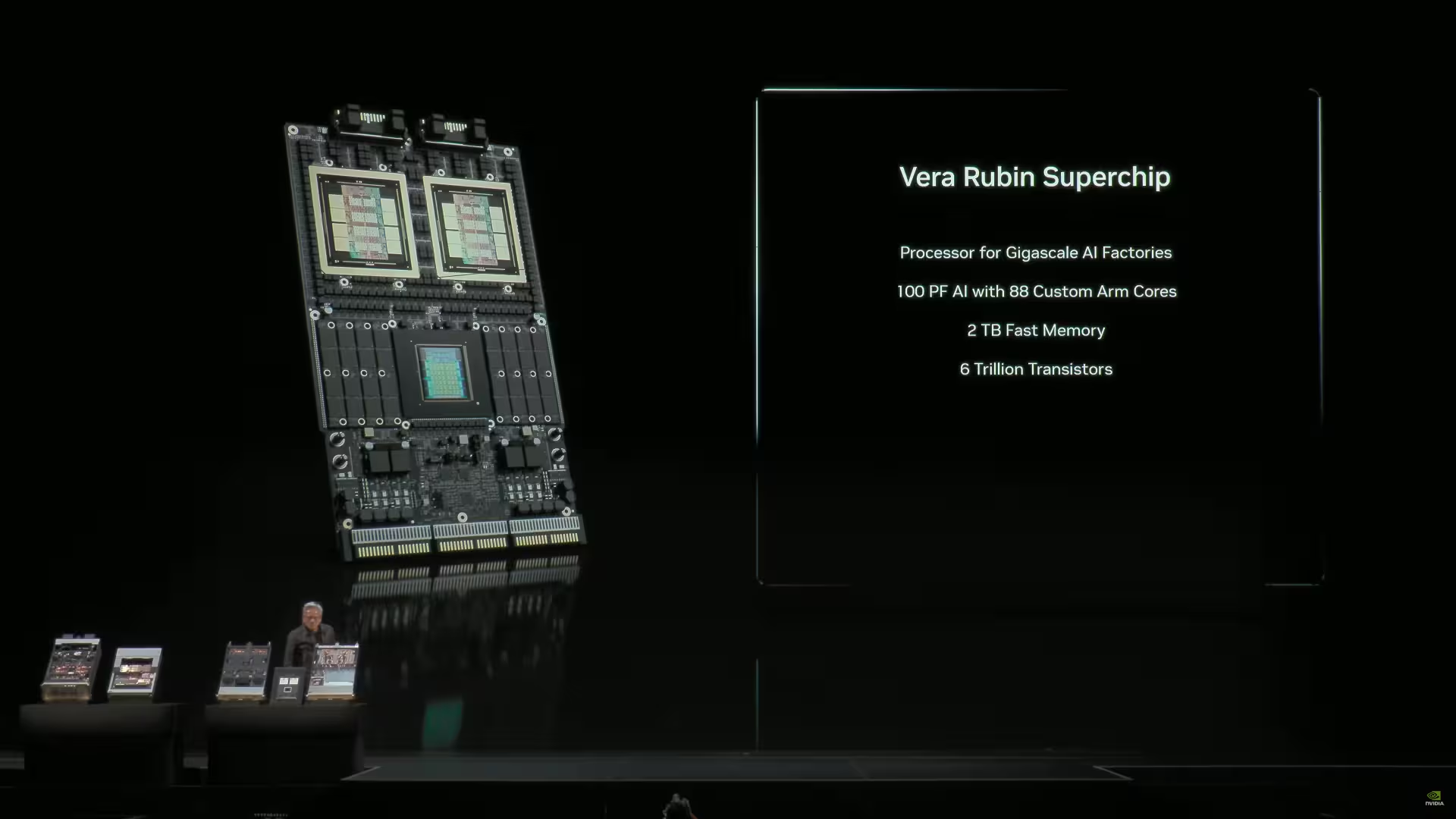

در کنفرانس GTC 2025 شرکت NVIDIA برای نخستینبار نمای عمومی از سوپرچیپ Vera Rubin را نشان داد؛ یک پکیج عظیم شامل دو واحد پردازشگر گرافیکی (GPU) بزرگ که روی هم چیده شدهاند، بههمراه یک پردازنده مرکزی Vera و مجموعهای از حافظههای LPDDR در لبهها برای مدیریت ترافیک کنترلی. این رونماییِ اولیه تصویری از جهتگیری سختافزاری انویدیا در شتابدادن به مدلهای بزرگ هوش مصنوعی (AI) بود. حالا گزارشها حاکی است که روبین از مرحله دموی آزمایشگاهی فراتر رفته و نمونههایی از آن روی خطوط تولید مشاهده شدهاند، و همزمان انویدیا نمونههای حافظه HBM4 را از هر یک از تامینکنندگان بزرگ حافظه DRAM دریافت کرده است. این انتقال سریع از نمونه آزمایشی به سطح تولید اولین نشانهها را درباره آمادگی روبین برای ورود به زیرساخت مراکز دادههای hyperscale نشان میدهد.

From demo to assembly line: what changed

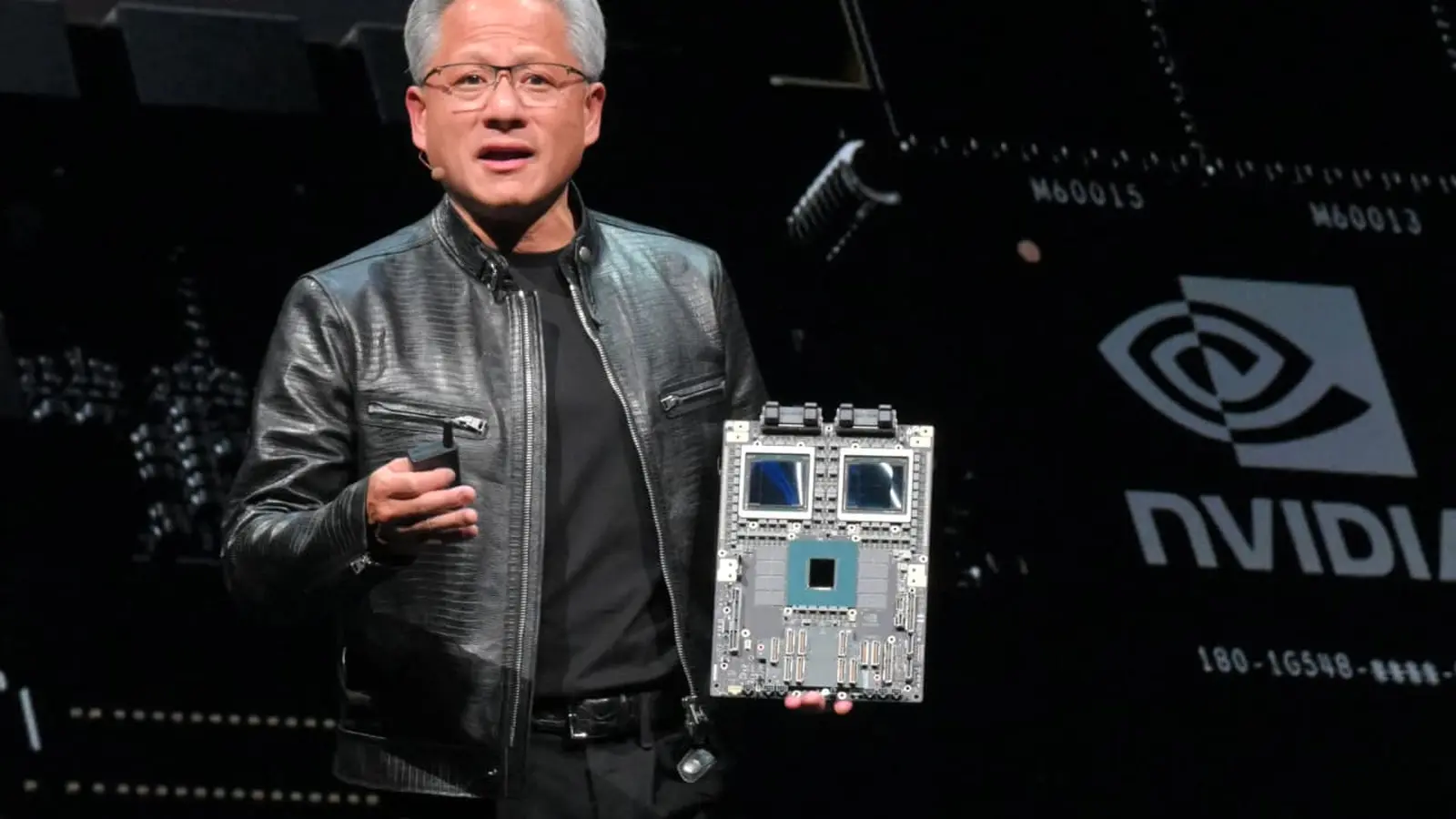

در جریان بازدید اخیر مدیرعامل انویدیا، جنسن هوانگ، از کارخانه TSMC گزارش شده که او تایید کرده تراشههای روبین در خطوط تولید دیده شدهاند. این خبر پس از اعلام قبلی انویدیا درباره ورود نمونههای آزمایشگاهی به مرحله بازرسی داخلی مطرح شد؛ حرکتی که بهطور غیرمعمولی سریع از نمونه اولیه به حضور روی خطوط تولید تبدیل شده است. اگر این اطلاعات صحیح باشد، زمانبندی رونمایی و عرضه روبین برای بازار شتابدهندههای AI—بهویژه در مراکز داده بزرگ—میتواند تسریع شود و باعث شود اپراتورهای ابری و سرویسدهندگان زیرساختی برنامههای خود برای نسل بعدی شتابدهندهها را بازنگری کنند.

این تغییر وضعیت از دموی کنترلشده در آزمایشگاه به حضور در خط تولید بهمعنای تائید پاهای فنی متعددی است: یک، سیلیکون اولیه باید معیارهای عملکرد و بازده انرژی را نشان داده باشد؛ دو، فرایند بستهبندی (packaging) و خنکسازی در نمونههای پیشتولیدی باید قابل اعتماد تشخیص داده شده باشد؛ و سه، آزمایشهای سازگاری با نرمافزار و درایورها تا حدی پیش رفته که نمونهها شایستگی ورود به آزمایشهای میدانی را داشته باشند. همه این مراحل ترکیبی از مهندسی سیلیکون، طراحی برد و برنامهریزی زنجیره تامین هستند که در کنار هم مسیر سریعتری را نسبت به قبل برای رسیدن یک نوآوری سختافزاری به بازار هموار میکنند.

از منظر فنی، سوپرچیپ Vera Rubin طراحی ترکیبیای را نشان میدهد که برای کار با مدلهای زبانی بزرگ و مدلهای مولد نسل بعدی بهینه شده است: اتصال نزدیک دو GPU قدرتمند به پردازنده مرکزی Vera و حافظه LPDDR برای عملیات کنترلی و مدیریت دادههای کمپهنای باند، در حالی که حافظه اصلی با پهنای باند بالا (مانند HBM4) به عنوان لایهی حافظهی سریع برای ماتریسها و محاسبات اصلی مدلها خدمت میکند. این نوع آرایش به انویدیا امکان میدهد تا بهرهوری انرژی و ظرفیت محاسباتی را در سطحی که مراکز داده ابری و مشتریان hyperscale انتظار دارند، بهبود بخشد.

Supply chain moves: TSMC steps up, HBM4 arrives

تقاضا برای خانوادهی Blackwell انویدیا همچنان بسیار بالا است و TSMC به عنوان یکی از تولیدکنندگان پیشرو نیمههادی تلاش کرده است تا با افزایش ظرفیت پاسخ دهد. بر اساس گزارشها، TSMC ظرفیت تولید در لیتوگرافی 3 نانومتری را حدود 50 درصد افزایش داده است تا بتواند سفارشهای انویدیا را پشتیبانی کند. سیسی وی، رئیس TSMC، نیز تایید کرده که انویدیا درخواست تعداد ویفرهای بسیار بیشتری نسبت به گذشته دارد، هرچند ارقام دقیق را «محرمانه» توصیف کرده است. این افزایش ظرفیت نشاندهنده تنش قابل توجه در زنجیره تامین تراشههاست؛ بهخصوص هنگامی که چندین بازیگر بزرگ در صنعت نیمههادی همزمان به فناوریهای تولید پیشرفته نیاز دارند.

در سمت حافظه، گزارشها حاکی از آن است که انویدیا نمونههای HBM4 را از همه تامینکنندگان عمده DRAM دریافت کرده است. حافظه HBM4 با هدف ارائه پهنای باند بسیار بالا و تاخیر پایین طراحی شده است؛ ویژگیهایی که برای اجرای مدلهای بزرگ AI و عملیات ماتریسی فشرده حیاتی است. دسترسی به نمونههای HBM4 از چندین تامینکننده یک استراتژی منطقی برای کاهش ریسک کمبود عرضه است؛ بهویژه وقتی تقاضا برای شتابدهندههای AI و کارتهای سروری در سطح جهانی افزایش مییابد. دستیابی به تامینکنندگان جایگزین همچنین انویدیا را در موقعیتی قرار میدهد که بتواند مذاکره برای قیمت و برنامه تحویل را انعطافپذیرتر انجام دهد.

عملکرد و سازگاری HBM4 در سیستمهایی مانند Rubin نیاز به هماهنگی نزدیک بین تیمهای طراحی سیستم، مهندسان نرمافزار و تامینکنندگان حافظه دارد. به عنوان مثال، مدیریت مصرف انرژی، چیدمان (layout) بورد، روشهای خنکسازی و کنترل یکپارچه خطای حافظه (ECC) از جمله مولفههایی هستند که باید همزمان مورد توجه قرار بگیرند تا عملکرد و قابلیت اطمینان در حجم انبوه تولید حفظ شود. در عمل، این یعنی نمونههای اولیه حافظه باید در پیکربندیهای مختلف سختافزاری آزمایش شوند تا تأیید شود که در سناریوهای واقعی مرکز داده، پهنای باند وعده دادهشده و تاخیر موردنظر بهدست میآید.

Timing, mass production and what to expect

انویدیا اعلام کرده که روبین ممکن است حوالی سهماهه سوم 2026 وارد تولید انبوه شود یا حتی زودتر. اما باید بین تولیدات اولیه ریسک (risk-production) و تولید انبوه تمامعیار تفاوت قائل شد: تولیدات اولیه و خطوط پایلوت برای اعتبارسنجی سیلیکون، فرآیند بستهبندی و تستهای حرارتی و پایداری به کار میروند، در حالی که تولید انبوه نشاندهنده آغاز عرضههای حجمی به ارائهدهندگان ابری، سازندگان سرور (OEM) و مشتریان سازمانی است. برای رسیدن به تولید انبوه، معمولاً چندین دوره بازخورد فنی، اصلاحات firmware/driver و بهبودهای تولیدی لازم است.

انتظار میرود در مرحله تولید انبوه، انویدیا بر معیارهایی مانند میانگین خرابی در زمان سرویس (MTBF)، بازده تولید (yield) و هزینه هر واحد توجه ویژهای داشته باشد. کاهش زمان تا فروش (time-to-market) و تضمین تداوم عرضه برای مشتریانی که برنامه ارتقاء مراکز داده را دارند، از عوامل کلیدی موفقیت در فاز تجاریسازی خواهد بود. همچنین راهبرد توزیع HBM4 از چند تامینکننده میتواند به حفظ روند تولید در مواجهه با مشکلات زنجیره تامین کمک کند.

بهعلاوه، روبین هماکنون با سرمایهگذاریهای تجاری بزرگ گره خورده است. نقشه راه (roadmap) انویدیا و گزارشها درباره قرارداد چند میلیارد دلاری با OpenAI نشان میدهد که این شتابدهندهها میتوانند موتور نسل بعدی استقرار مدلهای مقیاسپذیر AI باشند. اگر همکاریهای تجاری و قراردادهای ابری جلو بروند، تقاضا برای بردها و کارتهای مبتنی بر روبین ممکن است طی چند فصل افزایش یابد که این مسئله نیاز به هماهنگی بین تامینکنندگان تراشه، تولیدکنندگان برد و اپراتورهای مرکز داده را تشدید میکند.

Why this matters for AI infrastructure

تصور کنید مراکز دادهای که با شتابدهندههای کلاس روبین و حافظه HBM4 تجهیز شدهاند: توان عملیاتی بالاتر، زمان آموزش کوتاهتر برای مدلهای بزرگ، و خوشههای inference متراکمتر و کارآمدتر. برای ارائهدهندگان ابری، سازندگان چیپ و آزمایشگاههای هوش مصنوعی، حرکت روبین به سمت تولید همراه با افزایش ظرفیت TSMC و تامین HBM4 از چند فروشنده، ریسکهای گلوگاهی را هنگام رشد ابعاد مدلها کاهش میدهد. این وضعیت میتواند به رشد سریعتر آموزش مدلهای بزرگ و استقرار آنها در محصولات و خدمات واقعی کمک کند.

رقابت در سطح بازار تراشههای شتابدهنده AI با عرضه روبین بهصورت بالقوه پیچیدهتر خواهد شد: بازیگران بازار باید بین بهینهسازی عملکرد خام (raw performance)، مصرف انرژی، قابلیت ادغام نرمافزاری و هزینههای کلی انتخاب کنند. علاوه بر GPUs سنتی، رقابت شامل CPUهای سفارشی، شتابدهندههای اختصاصیِ مبتنی بر ماتریس (matrix engines) و شتابدهندههای مبتنی بر NPU خواهد بود. انتخاب هر یک از این معماریها توسط اپراتورهای مراکز داده تحت تأثیر معیارهای اقتصادی و فنی مانند هزینه به ازای هر ترابایت عملیات، قابلیت پشتیبانی از فریمورکهای نرمافزاری رایج (مثل CUDA، TensorRT، یا کتابخانههای متن باز)، و سازگاری با استانداردهای انرژی و خنکسازی قرار میگیرد.

در نهایت، داستان روبین تا این لحظه نمایانگر تقاضای شدید بازار، حمایت فعالfoundryها مثل TSMC و آمادهسازی تامینکنندگان حافظه برای عرضه HBM4 است. این معادله نشان میدهد که صنعت در آستانه جهش جدیدی در محاسبات شتابیافته برای هوش مصنوعی است؛ جهشی که میتواند نحوه آموزش و استقرار مدلها را تغییر دهد، هزینههای عملیاتی مراکز داده را متحول کند و فرصتهای جدیدی برای توسعهدهندگان نرمافزار و سرویسدهندگان ابری به وجود بیاورد.

در چشمانداز گستردهتر، موفقیت روبین در تولید انبوه و استقرار واقعی در مراکز داده، معیاری برای توانایی اکوسیستم نیمههادی در هماهنگی سریع بین طراحی، تولید و عرضه جهانی خواهد بود. اگر تمام قطعات—از طراحی سیلیکون و بستهبندی تا تامین HBM4 و افزایش ظرفیت تولید—بهدرستی در کنار هم قرار گیرند، شاهد افزایش شتاب در نوآوریهای بعدی در حوزه هوش مصنوعی خواهیم بود؛ نوآوریهایی که مستقیماً بر سرعت توسعه مدلهای زبانی بزرگ، پردازش تصویر و ویدئو، و برنامههای تحلیلی سنگین موثر خواهند بود.

منبع: wccftech

نظرات

آرمین

تصور مراکز داده با روبین جذابه؛ اگر TSMC و تامینکنندهها هماهنگ بمونن، سرعت نوآوری پرشتاب میشه. اما تا تولید انبوه هنوز راهه

شهرلاین

خیلی شانسه، ولی یه کم بزرگنمایی حس میشه، قراردادهای چند میلیاردی معمولا حرف و عمل جدا دارن... صبر میکنم تا ببینم

لابکور

تو شرکت ما هم یهبار همین سرعت انتقال از demo به تولید پیش اومد، کلی دردسر فت شد تا firmware درست شه، روبین هم احتمالا همین راهه

توربوآر

معقول به نظر میاد، ولی اگه HBM4 توی عمل خراب کنه چی؟ مصرف برق و خنکسازی مهمه

کوینپایل

این خبرها واقعین؟ TSMC ظرفیت 50%؟ بذار ببینیم قیمتها چی میشه، یه جای کار بوی تبلیغ میاد...

دیتاپالس

وای! اگه واقعیه یعنی مراکز داده دارن یه جهش واقعی میگیرن، ولی نکنه تولید انبوه هم مثل وعدهها نشه... هیجان زدهم، ولی شک دارم

ارسال نظر