10 دقیقه

تحقیقات جدید دانشگاه پنسیلوانیا نشان میدهد که هوش مصنوعی میتواند از تصاویر چهره نشانههای مرتبط با شخصیت استخراج کند و از این طریق نتایج شغلی افراد را پیشبینی نماید. این یافته سؤالات مهمی درباره خودکارسازی روندهای استخدام، تصمیمگیری در اعطای اعتبار و اخلاق استفاده از تحلیل چهره بهعنوان شاخص قابلیت اشتغال مطرح میکند. در مواجهه با این فناوری، پرسشهایی درباره حریم خصوصی، تبعیض الگوریتمی و شفافیت تصمیمگیری خودکار بوجود میآید که نیازمند بررسی دقیق سیاستگذاران، پژوهشگران و کارفرمایان است.

چطور مطالعه انجام شد — چهرهها، الگوریتمها و «پنج عامل بزرگ»

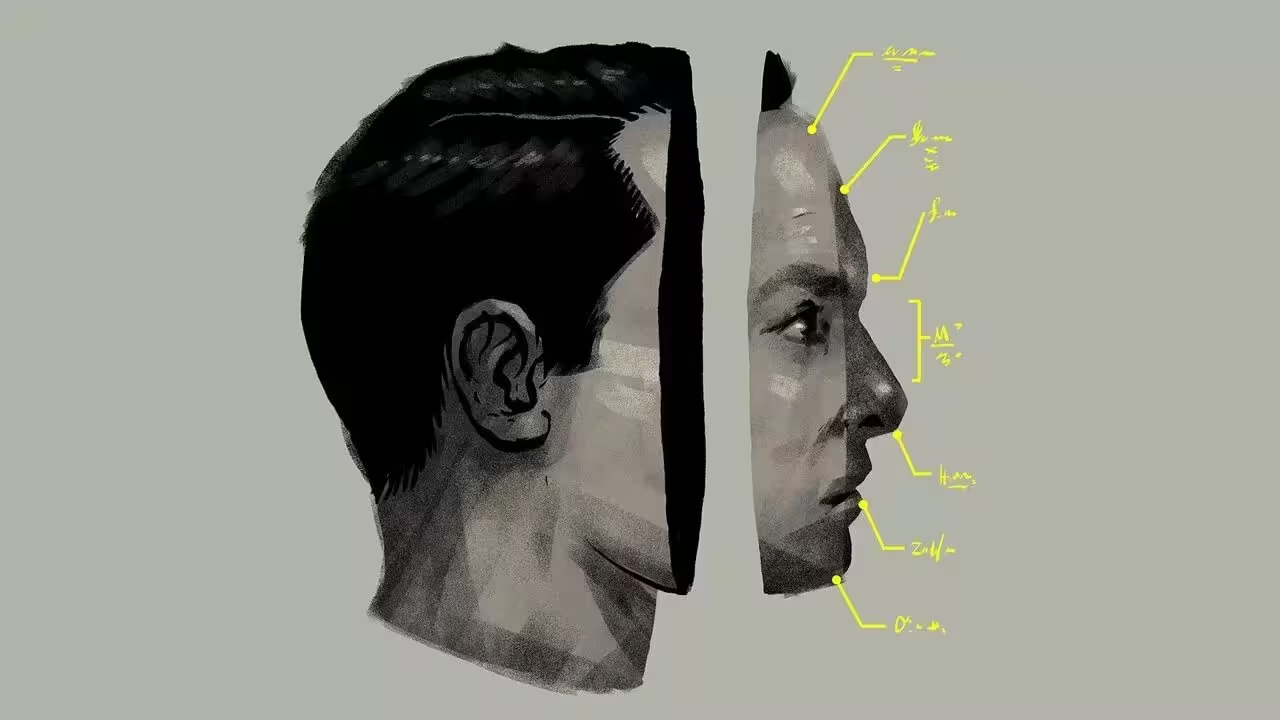

تیم پژوهشی یک مدل یادگیری ماشین را بر پایه پژوهشهای قبلی که ارتباط ظاهری صورت را با صفات شخصیتی بررسی کرده بودند آموزش داد. پژوهشگران، تصاویر پروفایل حدود 96٬000 فارغالتحصیل برنامه MBA را از شبکه اجتماعی LinkedIn گردآوری کردند و از یک سامانه هوش مصنوعی برای برآورد پنج صفت اصلی شخصیت — گشودگی (openness)، مسئولیتپذیری (conscientiousness)، برونگرایی (extraversion)، سازگاری (agreeableness) و روانرنجوری (neuroticism) — که مجموعه «Big Five» نامیده میشود، استفاده کردند. این ترکیب دادهمحور شامل تحلیل تصویر، یادگیری الگوها و پیوند زدن نتایج با متغیرهای بازار کار بود.

در این مرحله، تیم مطالعه تلاش کرد رویکردی فنی و روانشناختی را ترکیب کند: از یکسو، روشهای پردازش تصویر و شبکههای عصبی عمیق برای استخراج ویژگیهای چهره بهکار رفت؛ از سوی دیگر، نظریهها و مقیاسهای روانسنجی برای تفسیر صفات شخصیتیِ متناظر بهعنوان متغیرهای هدف استفاده شد. برای افزایش اعتبار یافتهها، پژوهشگران معیارهای کنترل مانند سن، جنسیت، رشته تحصیلی و سابقه کاری را نیز در تحلیلهای آماری لحاظ کردند تا همبستگیهای مشاهدهشده را نسبت به عوامل بیرونی بسنجند.

از پیکسل تا نمرههای شخصیتی

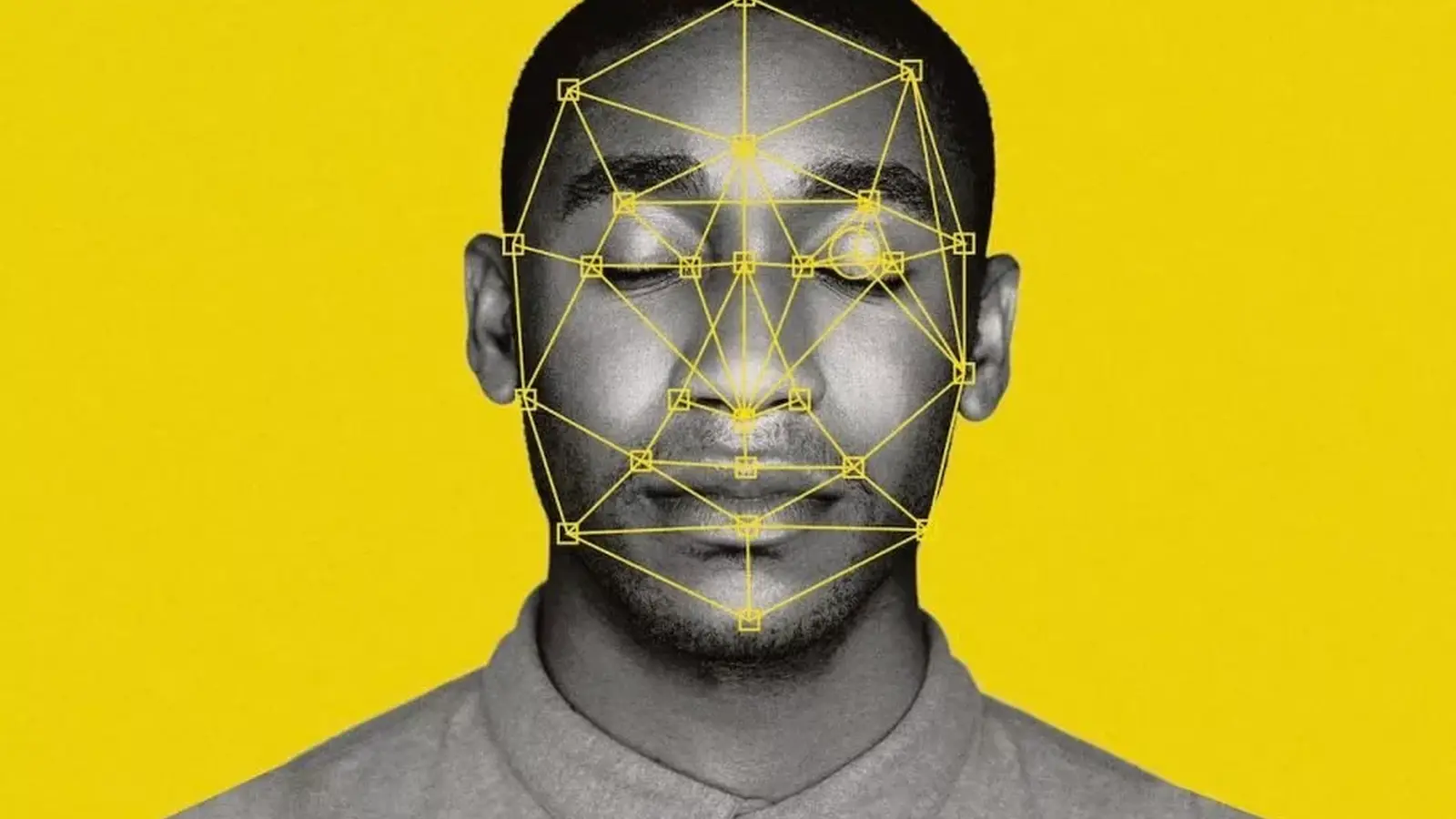

سامانه هوش مصنوعی ویژگیهای ظاهری چهره مانند شکل کلی صورت، نسبتهای هندسی، حالات ظریف عضلات اطراف چشم و دهان، و الگوهای نور و سایه را اسکن کرد و بر پایه مدلهای آماری و شبکههای عصبی، برآوردهایی از نمرههای مربوط به هر یک از پنج عامل بزرگ ارائه داد. سپس پژوهشگران این برآوردهای هوش مصنوعی را با معیارهای شغلی واقعی مانند درآمد، پیشرفت شغلی و دیگر نتایج بازار کار مقایسه نمودند تا رابطه بین برآوردهای شخصیتی و خروجیهای اقتصادی بررسی شود.

تحلیلها نشان داد که همبستگیهای آماری معنیداری وجود دارد: برونگراییِ برداشتشده از چهره بهعنوان قویترین پیشبین مثبت درآمد بالاتر شناخته شد، در حالی که گشودگیِ برداشتشده در این نمونه با درآمد کمتر ارتباط داشت. این نتایج البته به معنی علت و معلول نیست؛ بلکه نشان میدهد که مدل توانسته الگوهایی را شناسایی کند که با تفاوتهای درآمدی همسو هستند. پژوهشگران همچنین تاکید کردند که دقت مدل بسته به زیرگروههای جمعیتی و زمینههای فرهنگی متفاوت است و ممکن است در گروههای متفاوت خطاهای سیستماتیک تولید کند.

چرا این موضوع اهمیت دارد: استخدام، اعطای اعتبار و عدالت الگوریتمی

تصور کنید سیستمهای غربالگری خودکار که علاوه بر رزومه و مصاحبه، لایهای از تحلیل چهره را نیز اضافه میکنند. بر اساس گزارش نهایی که در SSRN منتشر شد و پوشش رسانهای در مجله The Economist، شرکتهایی که با انگیزههای اقتصادی هدایت میشوند ممکن است از ابزارهای تحلیل چهره برای پالایش تصمیمات استخدامی، اجاره مسکن یا تخصیص اعتبارات استفاده کنند. این چشمانداز برای بسیاری نگرانکننده است: رد متقاضیان به دلیل پیشبینی «صفات نامطلوب» از روی صورت احتمالاً باعث تثبیت سوگیریها و نقض مقررات ضدتبعیض خواهد شد.

پیوند دادن نتایج گفتهشده به خطمشیهای منابع انسانی یا تعیین نهایی صلاحیت متقاضیان، میتواند منجر به انقباض فرصتهای شغلی برای گروههای خاص شود. بهعلاوه، هنگامی که تصمیمگیرندگان مالی — مانند بانکها یا شرکتهای بیمه — بر پایه حدسهای الگوریتمی از شخصیت، رفتار اقتصادی یا ریسک اعتباری را اندازهگیری کنند، مخاطرات نهادی و اجتماعی افزایش مییابد. علاوه بر این، وقتی دادههای آموزش مدلها از مجموعههای ناهمگون یا جانبدار انتخاب میشوند، الگوریتمها میتوانند تبعیضات ساختاری را بازتولید یا تشدید کنند.

مسئله عدالت الگوریتمی (algorithmic fairness) چند بعد دارد: یک بعد فنی شامل معیارهای آماری برای اندازهگیری تبعیض، دیگری مربوط به شفافیت و قابلیت بررسی (auditability) مدلهاست، و بعد سوم مربوط به اقدامات قانونی و نظارتی است که میتواند استفاده نادرست از این فناوری را محدود کند. سیاستگذاران و دانشمندان داده باید در طراحی چارچوبهای نظارتی فعال باشند تا از همزیستی فناوری، عدالت و احترام به حقوق فردی اطمینان حاصل شود.

نویسندگان مطالعه بر احتیاط تاکید میکنند. آنها خروجیهای مدل را بهعنوان یک منبع اطلاعاتی اضافی توصیف میکنند — نه بهعنوان اثبات قطعی شخصیت یا سرنوشت آینده فرد. حوزه تحلیل چهره برای صفات رفتاری هنوز در مراحل اولیه توسعه است و دقت آن بین جمعیتها و بسترهای مختلف متفاوت است. خطاها و برداشتهای نادرست میتوانند نابرابریهای اجتماعی را تشدید کنند، بهخصوص اگر کارفرمایان، بانکها یا موجرها بیاجازه یا بدون بررسی نتایج الگوریتمی را بهعنوان مرجع تصمیمگیری تلقی نمایند.

از منظر اخلاقی، استفاده از تحلیل تصویر برای استنتاج ویژگیهایی که ذاتاً خصوصی یا قابلتفسیر هستند، نگرانیهای جدی ایجاد میکند. سازوکارهایی مانند شناسایی بایاس (bias detection)، مکانیزمهای توضیحپذیری (explainability)، و سیاستهای محافظت از داده باید همراه با هر گونه کاربرد عملی این تکنولوژی توسعه یابند تا آسیبهای احتمالی کاهش یابد.

مزایا احتمالی، ریسکهای واقعی و پیامدهای ناخواسته

با این حال، مقاله به پیامدهای رفتاری بلندمدت هشدار میدهد: استفاده گسترده از ابزارهای تحلیل چهره میتواند افراد را به تغییر یا دستکاری ظاهر خود، چه بهصورت دیجیتال (مانند فیلترها و ویرایش تصاویر) و چه بهصورت فیزیکی (مانند جراحیهای زیبایی)، ترغیب کند تا در سامانههای خودکار امتیاز بهتری کسب کنند. این رفتارهای واکنشی میتواند مسائل عمیقتری در حوزه سلامت روان و همبستگی اجتماعی ایجاد کند.

از منظر حقوقی و فنی، ابزارهای شناسایی چهره و استنتاج صفات با قوانین حریم خصوصی و مقررات ضدتبعیض تداخل دارند. در بسیاری از حوزهها هنوز قوانین روشنی برای استفاده از تحلیل چهره در تصمیمگیریهای حساس وجود ندارد یا مقررات در حال شکلگیریاند. بهعلاوه، از دید فنی، تضمین شفافیت و امکان بررسی (audit) مدلهای یادگیری عمیق که در چارچوبهای مالکیتی توسعه یافتهاند، چالشبرانگیز است؛ فقدان شفافیت میتواند باعث شود شواهدی که الگوریتمها ارائه میدهند برای افراد متضرر غیرقابلقبول یا غیرقابلدفاع به نظر برسد.

برای کاهش این ریسکها، پیشنهادهایی از جمله الزامات شفافیت در مدلسازی، حفظ سوابق تصمیمگیری خودکار، بررسیهای مستقل نسبت به مجموعههای داده و الگوریتمها، و خطوط راهنمای اخلاقی برای کاربردهای استخدام و اعطای اعتبار مطرح شدهاند. همچنین آموزشهای آگاهیبخش برای مدیران منابع انسانی و کارشناسان اعتباری درباره محدودیتها و ریسکهای تحلیل شخصیت از روی تصویر ضروری است.

بهعلاوه، راهحلهای فنی مانند محدود کردن ورودیها به اطلاعات کمتر حساس، استفاده از معیارهای معادلسازی (equity-aware) در هنگام طراحی مدل، و بهکارگیری تکنیکهایی برای کاهش بایاس در دادهها میتوانند نقش سادهای در کاهش پیامدهای نامطلوب داشته باشند؛ اما بهتنهایی کافی نیستند و باید با چارچوبهای قانونی و نظارتی همراه شوند.

چه چیزهایی را باید دنبال کرد — مسیر پژوهش و سیاستگذاری

پژوهشگران در حال ادامه آزمایشها هستند تا مشخص شود آیا سیگنالهای برداشتشده از چهره در بازارهای شغلی و گروههای جمعیتی مختلف ارزش پیشبینیکننده قابلاعتمادی دارند یا خیر. بازتولید مستقل نتایج، انتشار مجموعههای داده باز و بحث عمومی و سیاستگذاری شفاف برای تعیین مصارف مشروع — اگر هرگونه مصارف مشروعی وجود داشته باشد — حیاتی است. بدون دادههای باز و بازتولیدپذیر، ادعاهای مربوط به عملکرد الگوریتمها دشوار بهکار برده یا بررسی میشوند.

مسیر پژوهشی باید شامل آزمونهای میانفرهنگی، آنالیز حساسیت برای زیرگروههای جمعیتی و ارزیابی اثرات جانبی باشد. همچنین ضروری است که مطالعات آینده روشن سازند چه نسبتی از همبستگیهای مشاهدهشده ناشی از عوامل محیطی، انتخاب شغلی یا ساختارهای نهادی است، و چه نسبتی واقعاً از خصوصیات ثابت شخصیت سرچشمه میگیرند. برای این منظور استفاده از روشهای تلفیقی که دادههای طولی (longitudinal)، کیفی و کمی را ترکیب میکنند، توصیه میشود.

در سطح سیاستگذاری، سه محور کلیدی عبارتند از: تدوین چارچوبهای حقوقی محافظت از حریم خصوصی بصری، تنظیم مقررات برای کاربردهای تصمیمگیر خودکار در حوزههای حساس (مانند استخدام و اعطای اعتبار)، و ایجاد زیرساختهای بررسی و ارزیابی مستقل برای الگوریتمها. این سه مولفه میتواند به کاهش خطرهای اجتماعی کمک کند و در عین حال فضای نوآوری مسئولانه را نیز حفظ نماید.

فعلاً این مطالعه یادآور این نکته است که یادگیری ماشین توانایی کشف الگوهایی را دارد که انسانها ممکن است آنها را نادیده بگیرند — اما الگو برابر با اثبات نیست. سیاستگذاران، کارفرمایان و فناوران باید منفعت احتمالی را در برابر خطرات مربوط به عدالت، حریم خصوصی و اختیار فردی بسنجند و پیش از هر گونه بهکارگیری عملی، استانداردها و مکانیسمهای حفاظتی مناسبی را برقرار کنند.

در پایان، گفتگوهای بینرشتهای میان علوم داده، حقوق، علوم انسانی و مدیریت منابع انسانی برای شکلدهی رویکردهای مسئولانه نسبت به تحلیل شخصیت از روی تصویر ضروری است. تنها با ترکیب دیدگاههای فنی و اخلاقی میتوان اطمینان حاصل کرد که فناوریهایی از این دست در خدمت عدالت اجتماعی قرار گیرند و نه به تقویت نابرابریها کمک کنند.

منبع: smarti

نظرات

پمپزون

تو شرکت سابقمون یه ابزار اومد شبیه این، اول خیلی قانعکننده بود اما بعدا دیدم نتایج گروهی رو حذف میکنه، هشدار بدم به بقیه، مراقب باشین

لابکور

خوب مطالعه جالبیه، ولی احساس میکنم اغراق دارن... دادههاو مدلها نیاز به بررسی بیشتر دارن، توضیحپذیری کجاست؟

آرمین

واقعا؟ این روش چطور با تفاوتهای فرهنگی کنار میاد، اگه دادهها جانبدار باشن نتیجهها الکیه, یا من اشتباه میکنم؟

دیتاپالس

وای، این دیگه خیلی ترسناکه... اینکه از عکس بتونن شخصیت و بعد درآمد رو پیشبینی کنن، یعنی کلی تبعیض پنهان ممکنه رخ بده، باید قانون باشه.

ارسال نظر