9 دقیقه

یک یافته غیرمنتظره از یک تحقیق مشترک بین دانشگاه مریلند و مایکروسافت: زبان لهستانی در میان 26 زبان توانست بهعنوان مؤثرترین زبان برای نوشتن پرامپتها در مقابل مدلهای زبانی بزرگ قرار بگیرد، در حالی که انگلیسی تنها در رتبه ششم ایستاد.

چگونه پژوهشگران عملکرد زبانها را با هوش مصنوعی آزمودند

تیم تحقیقاتی مجموعهای از پرامپتهای یکسان را به 26 زبان مختلف ترجمه کرد و همین پرسشها را به تعدادی از مدلهای بزرگ زبان (LLM) داد — از جمله مدلهای OpenAI، Google Gemini، Qwen، Llama و DeepSeek — و سپس دقت پاسخها در انجام وظایف را اندازهگیری کردند. برخلاف انتظار، زبان لهستانی در صدر قرار گرفت و میانگین دقت وظایف برای آن برابر با 88% گزارش شد.

نویسندگان گزارش این نتایج را «غیرمنتظره» توصیف کردند و تأکید کردند که انگلیسی همیشه برنده کلی نیست. در ارزیابیهای متونی بلندتر، انگلیسی در جایگاه ششم قرار گرفت درحالیکه لهستانی پیشتاز بود. این مطالعه نشان میدهد انتخاب زبان میتواند بهطور ملموسی کیفیت خروجی مدل را تحتتأثیر قرار دهد و بنابراین در زمینههای مهندسی پرامپت و توسعه مدلهای چندزبانه اهمیت دارد.

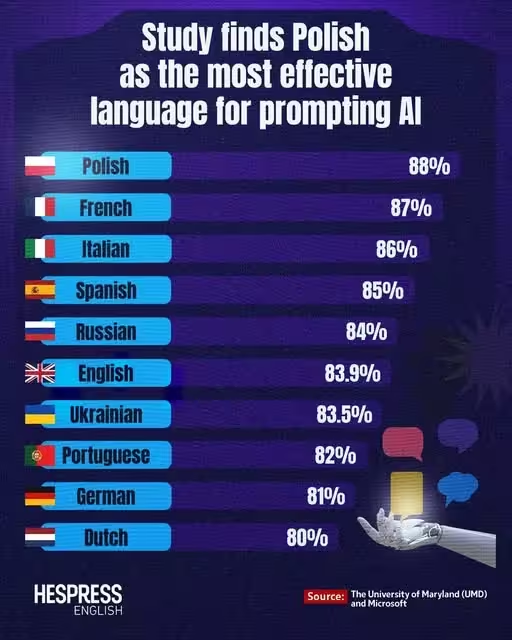

بهترین زبانها برای پرامپتدهی به AI — جدول رتبهبندی مطالعه

در اینجا ده زبان برتر از دید مطالعه، بهترتیب میانگین دقت، آمده است:

- لهستانی — 88%

- فرانسوی — 87%

- ایتالیایی — 86%

- اسپانیایی — 85%

- روسی — 84%

- انگلیسی — 83.9%

- اوکراینی — 83.5%

- پرتغالی — 82%

- آلمانی — 81%

- هلندی — 80%

چرا ممکن است لهستانی برای پرامپتها بهتر عمل کند؟

چند نظریه میتواند این نتیجه متناقض با شهود را توضیح دهد. لهستانی زبانی است با ساختار صرفی پیچیده (morphologically rich) و قواعد املایی نسبتاً سازگار که ممکن است منجر به تولید توکنهایی شود که با روشهای توکنسازی ترنسفورمرها (transformer tokenization) بهتر هماهنگ باشند. این سازگاری توکنها میتواند پرامپتها را برای مدل شفافتر کند، حتی اگر دامنه نمونههای آموزشی لهستانی کمتر از انگلیسی باشد.

عامل دیگر ابهام و نحوه بیان پرسشهاست: بعضی زبانها بهطور طبیعی باید نشانههای دستوری صریحتری را ارائه دهند، چیزی که احتمال برداشت نادرست نیت کاربر را کاهش میدهد. به عبارت دیگر، زبانی که برای انسانها «دشوار» بهشمار میآید لزوماً برای مدلهای زبانی سخت نیست؛ مدلها میتوانند الگوهای ساختاری را مستقل از سختی یادگیری برای انسانها یاد بگیرند.

از سوی دیگر، چینی در این ارزیابی در نزدیکی پایین فهرست (چهارمین از انتها) قرار گرفت، که نشان میدهد داشتن دادههای آموزشی زیاد بهتنهایی تضمینکننده عملکرد بهتر پرامپت در همه زبانها نیست. ترکیب دادهها، نمایندگی ساختاری و نحوه توکنسازی میتواند نتایج را بهشدت تغییر دهد.

برای درک بهتر، لازم است به دو جنبه فنی نگاه کنیم: ابتدا توکنسازی (tokenization) — چگونه متن به واحدهای ورودی مدل تبدیل میشود — و دوم توزیع دادههای آموزشی (training data distribution). توکنسازها معمولاً بهدنبال تعادل بین تعداد توکنها و پوشش واژگان هستند؛ زبانی که واژگان و صرف آن بهگونهای باشد که توکنها طول و ترکیب مطلوبی داشته باشند، ممکن است در تعامل با مدل عملکرد بهتری نشان دهد.

علاوه بر این، پیچیدگی نحوی و ساختار جملهها در لهستانی ممکن است باعث شود مفهومهایی که در انگلیسی بهصورت ضمنی بیان میشوند، در لهستانی بهصورت صریحتری به نمایش درآیند که در نهایت به کاهش خطاهای تفسیر توسط مدل منجر میشود. این نکته به ویژه در وظایف نیازمند دستورالعمل دقیق، ترجمه تخصصی یا خلاصهسازی فنی اهمیت دارد.

جزئیات فنی: توکنسازی، توزیع داده و معیارهای ارزیابی

شرح فنی روش آزمایش و معیارهای اندازهگیری به فهم علت نتایج کمک میکند. پژوهشگران از مجموعهای استاندارد از وظایف (tasks) شامل پاسخدهی به سوالات باز، خلاصهسازی متن، طبقهبندی و استنتاج متنی استفاده کردند و عملکرد مدلها را با معیارهای کمی مانند دقت (accuracy)، F1 و میزان همپوشانی معنایی ارزیابی نمودند.

در سطح توکنسازی، روشهای مختلفی وجود دارند: بایتپیر (Byte-Pair Encoding)، وردپِس (WordPiece) و الگوریتمهای مبتنی بر زیرواحدها (subword). هر یک از این روشها برای زبانهای با مشخصههای متفاوت نتایج گوناگونی تولید میکنند. اگر توکنساز بهصورت طبیعی بتواند تکههای معنیدار زبانی را استخراج کند، مدل ورودیهای واضحتر و کمابهامتری دریافت میکند.

از نظر توزیع داده، حتی اگر حجم کل دادههای انگلیسی بسیار بیشتر باشد، تعادل بین سبکهای نوشتاری، حوزههای موضوعی و سطح رسمی/غیررسمی بودن متنها در زبانهای دیگر میتواند مدل را درکی بهتر از ساختارهای دستوری و معنایی آن زبان بدهد. بنابراین کیفیت و پوشش دادهها در هر زبان نقش کلیدی دارد.

تبعات برای مهندسی پرامپت و هوش مصنوعی چندزبانه

پس از مشاهده چنین نتایجی، چه پیامهایی برای توسعهدهندگان، پژوهشگران و مهندسین پرامپت وجود دارد؟

- انگلیسی را همیشه بهترین فرض نکنید: پرامپتها را در چند زبان آزمایش کنید — ممکن است خروجی دقیقتر یا موجزتری را در زبانی غیرمنتظره دریافت کنید.

- در طراحی معیارهای چندزبانه و مجموعههای داده برای فاینتیونینگ، اثرات صرف و توکنسازی را درنظر بگیرید؛ این عوامل میتوانند اختلاف عملکرد قابل توجهی ایجاد کنند.

- برای استقرارهای بینالمللی، رفتار مدل را در زبانهای هدف ارزیابی کنید و از تعمیمدادن نتایج انگلیسیمحور خودداری نمایید.

تجربه عملی نشان میدهد که سازمانها باید ابزارها و پروتکلهایی برای ارزیابی عملکرد مولدهای متن (NLG) در زبانهای هدف توسعه دهند. این شامل طراحی بنچمارکهای بومی، جمعآوری دیتاست متوازن برای هر زبان و نظارت مستمر پس از استقرار میشود. علاوه بر این، مهندسی پرامپت (prompt engineering) باید یک فرایند آزمایشی و تکرارشونده باشد که در آن زبانهای مختلف برای یافتن فرم بهینه پرسش و دستورالعمل بررسی شوند.

یک پیام جالب از این مطالعه در شبکههای اجتماعی این بود که اداره ثبت اختراعات لهستانی (Polish Patent Office) اشاره کرد که نتایج نشان میدهد لهستانی دقیقترین زبان برای دستوردهی به AI است و با طنزی افزود: ممکن است انسانها یادگیری لهستانی را دشوار بدانند، اما هوش مصنوعی این مشکل را ندارد.

ملاحظات پژوهشی و محدودیتهای مطالعه

درک نتایج نیازمند توجه به محدودیتهای این تحقیق است. نخست، مجموعه وظایف و مدلهای انتخابشده بازتابدهنده تمام کاربردهای ممکن نیستند؛ نتایج برای وظایف دیگری (مثلاً چت تعاملی، تولید کد، یا پردازش گفتار) ممکن است متفاوت باشد. دوم، کیفیت و کمیت ترجمه پرامپتها میتواند اثرگذار باشد: ترجمههای ماشینی یا انسانی با کیفیتهای متفاوت میتواند تغییرات قابل توجهی در خروجی ایجاد کند.

علاوه بر این، تفاوت در نحوه پیشپردازش دادهها برای هر زبان، و نیز نسخهها و تنظیمات اولیه مدلها (pretraining hyperparameters)، ممکن است برخی از تفاوتها را توضیح دهد. پژوهشگران اشاره کردهاند که برای تایید نتایج باید مطالعات بازتولیدپذیر (reproducible) و گستردهتر انجام شود که شامل مدلها و بنچمارکهای مستقل باشد.

اقدامات پیشنهادی برای تیمهای مهندسی و محصول

برای تیمهایی که با مدلهای زبانی کار میکنند، چند راهبرد عملی پیشنهاد میشود:

- پیش از استقرار، بنچمارکهای چندزبانه بسازید و پرامپتها را در زبانهای مختلف ارزیابی و بهینه کنید.

- در فرایند فاینتیونینگ، از مجموعه دادههای متنوع و متوازن براساس حوزههای کاربردی و زبانها استفاده کنید.

- تحلیل توکنسازی را بخشی از چرخه توسعه کنید: بررسی کنید کدام توکنها و توالیها بیشترین تاثیر را در دقت دارند و آیا پیشپردازش خاص زبانی نیاز است یا خیر.

در طراحی محصول، به سیاستهای کاربری و چگونگی تفسیر دستورالعملها در زبانهای مختلف توجه کنید. مستندسازی دقیق و نمونههای کاربری (usage examples) را به زبانهای هدف اضافه نمایید تا کاربران محلی بتوانند پرامپتهای مؤثرتر بنویسند.

چه چیز بعدی خواهد آمد؟

پژوهشگران میگویند این نتیجه پایان کار نیست — نیاز به تحقیقات بیشتری هست تا بفهمیم چگونه توکنسازی، توزیع دادههای آموزشی و ساختار زبانشناختی رفتار مدل را شکل میدهند. مطالعات آتی باید به صورت سیستماتیک نقش هر یک از این عوامل را آزمایش کنند، از جمله:

- آزمودن مدلهای بیشتر و معماریهای متفاوت برای ارزیابی پایداری یافتهها.

- تحلیل دقیقتری از توکنها و زیرواحدها در هر زبان و تاثیر آنها بر طول ورودی و پیچیدگی پردازشی.

- بررسی بهتر توزیع و کیفیت دادههای آموزشی بهویژه در زبانهای با منابع کمتر (low-resource languages).

- ارزیابی وظایف دامنهمحور (domain-specific) تا اثر زبان در کاربردهای تخصصی مشخص شود.

در عین حال، این مطالعه جامعه هوش مصنوعی را به بازنگری در پیشفرضها وادار میکند: فرض اینکه انگلیسی همواره بهترین زبان برای تعامل با مدلهای زبانی است، دیگر بیچونوچرایی ندارد. پژوهش و آزمایش گستردهتر در مهندسی پرامپت، توکنسازی و طراحی داده میتواند نتایجی عملی برای توسعه و استقرار مدلهای چندزبانه به ارمغان بیاورد.

در نهایت، برای متخصصان حوزه NLP و توسعهدهندگان محصولات هوش مصنوعی، پیام روشن است: بهجای تکیه صرف بر تجربیات انگلیسیمحور، بازبینی سیستماتیک زبانها و شیوههای تعامل با مدلها را در دستور کار قرار دهید. این رویکرد کمک میکند تا خدمات هوش مصنوعی برای طیف گستردهتری از کاربران جهانی دقیقتر و قابلاعتمادتر شود.

منبع: smarti

نظرات

مکس_ای

تا وقتی فقط چند مدل و چند تسک بررسی شده، پرهیاهو به نظر میاد. اما ایدهش جذابه، باید عمقیتر بشه

آرمین

تحقیق جالبه، ولی محدودیتها مهمن. باید بنچمارکهای گسترده تر و تحلیل توزیع داده و توکنایزینگ رو ببینن

بیونیکس

تو پروژهٔ ما هم دیدم زبان غیرمنتظره بهتر جواب داد، مخصوصا وقتی توکنها تمیز درمیومدن, همینه

توربو

این دادهها قابلاعتمادن؟ ترجمه پرامپت و تنظیمات مدل همه میتونن نتایج رو تغییر بدن، شک دارم...

کوینپی

مطمئن نیستم اما منطقیه، انگلیسی همیشه سلطان نیست. یه آزمایش سریع لازمه تا حرفا تایید بشه

دیتاپالس

واقعا؟! لهستانی بهترینه؟ شوکه شدم ولی ایده توکنسازی منطقیه، باید ببینن بازتولیدپذیره...

ارسال نظر